王晓刚:商汤绝影引领智能汽车进入AGI时代 | GTC 2025

2025-03-21 17:41:39爱云资讯13714

3月17日下午,商汤科技联合创始人、首席科学家、商汤绝影CEO王晓刚在NVIDIA GTC 2025发表演讲《激发通用人工智能的创造力,引领智能汽车走向全新的未来》,以下为演讲实录:

各位开发者朋友大家好,我是绝影智能的王晓刚,感谢英伟达GTC活动的邀请,也非常感谢各位对绝影的关注与支持。

绝影智能是最专注汽车行业领先的AI公司,旨在推动智能汽车加速驶入通用人工智能时代。今天我想给大家分享绝影如何激发通用人工智能的创造力,引领智能汽车走向全新未来。

我常常在想AGI时代下的未来汽车出行是怎样的。它应该是可以实现更为自然的有温度的人车交互体验,让智能汽车从出行代步工具,进化为你的情感陪伴;同时它还要具备实现安全自动驾驶的能力,解放你的身心束缚,让你的时间和精力都可以投入到与世界的连接中,尽情享受大千世界的无限可能。

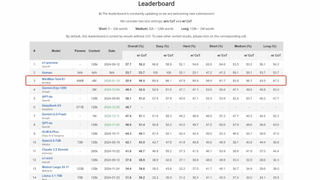

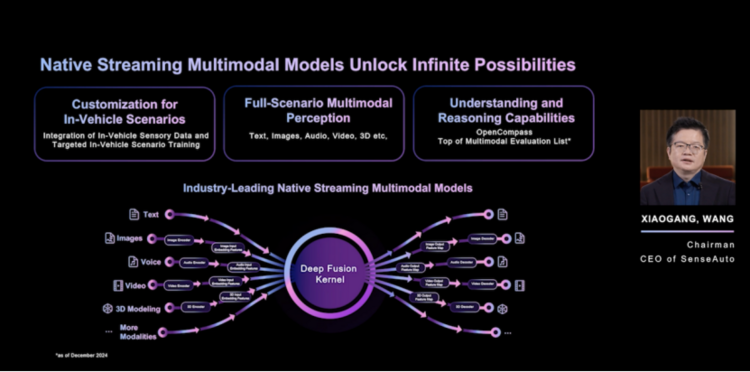

因此,我认为AGI赋能下为智能汽车带来的变革主要在三方面:

第一是通过原生流式多模态大模型带来的人机交互体验的变革;第二是通过端到端智驾技术的升级,带来极致自动驾驶安全和效率;第三是舱驾融合驱动智能汽车往超级智能体方向演进,极大拓展了人与物理和数字世界的连接。

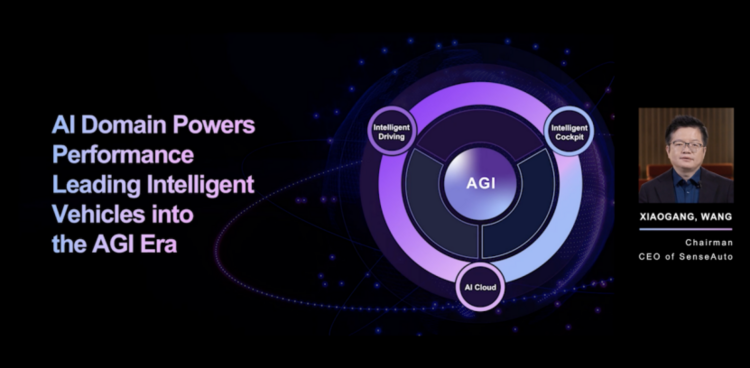

而引领智能汽车变革的核心驱动力,在于舱驾融合的AI域。绝影和英伟达深度合作,构建舱驾融合的三大核心要素,包括可支持舱驾融合的超大算力引擎,行业领先的原生流式多模态大模型,以及端云一体协同的部署框架。

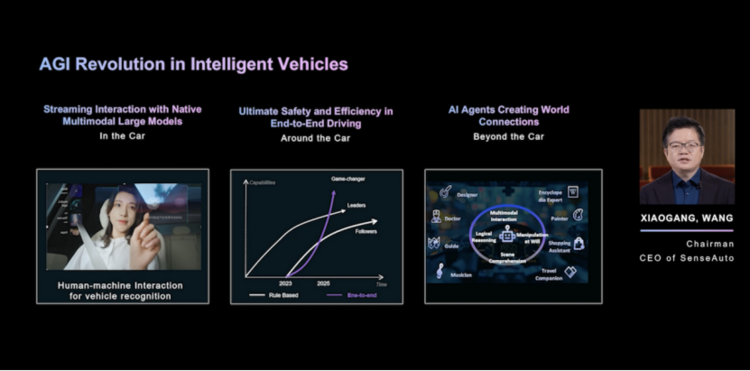

依托英伟达算力引擎,绝影首创舱驾融合AI域框架。

该框架包括三层,首先是最下面的算力层,它是依托NVIDIA车端计算平台DRIVE AGX及云端AI计算平台共同打造的强大算力引擎;中间是系统层,它包括以多模态和端到端为核心的车端大模型,和以世界模型和大语言模型为核心的云端大模型。

基于端云协同的部署模式,配合绝影自研的模型服务框架及工具,实现系统性能的全量释放,有效支撑最上面的应用层如自动驾驶、多模态交互、全时陪伴助理等多样化的整车级智能化生态应用。

为打造领先的舱驾融合AI域,首先我们需要构建超大算力引擎,以赋能舱驾多元化的智能应用。NVIDIADrive AGX平台超大算力引擎技术支持双芯方案,可实现大算力的翻倍扩展,提供安全的多域计算能力。

绝影在此基础上根据功能相关性和功能安全等级的不同划分出不同域,实现车身控制、端到端自动驾驶模型、多模态大模型、端到端语音模型等不同功能模型间的隔离保障,保障整车安全。

同时,超大算力引擎还具有高带宽的特点,可容纳约7个8B模型同时运行,配合绝影设计的AI Runtime Bus使得不同功能域运行的各个大模型在保障安全隔离的情况下也能高效通信。

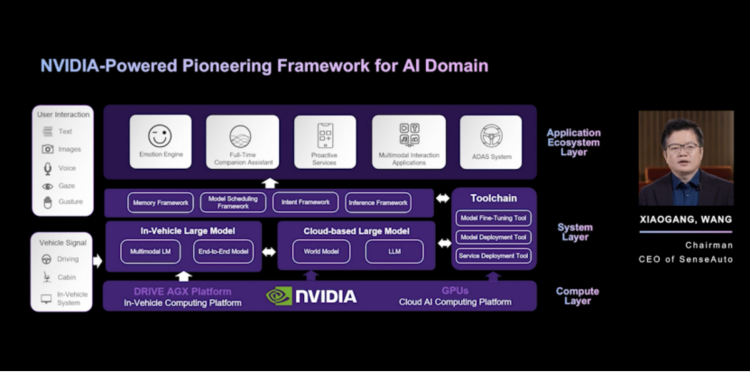

扎实的系统支撑是基础,而强大的模型能力能为车载应用开发带来无限可能。

绝影专为车载场景定制化打造的原生流式多模态大模型,以其全场景多模感知、理解和推理能力,让智能汽车有了类似人类的视觉、听觉和触觉能力,可将真实世界里包括语言、语音语调、表情、车载信号等丰富的模态信息以端到端优化的方式,准确感知和理解,并在OpenCompass多模态评测榜单中取得了第一的成绩。

在应用部署上,绝影制定了端云协同的部署策略,通过意图分流来进行任务在端云两侧的协同,当前场景任务有80%是在端侧处理。端云协同的方式可覆盖广泛的场景交互,保证安全可靠、实时响应,并充分保障个人隐私安全。

舱驾融合的AI域打开了智能汽车的性能上限,是引领智能汽车走向AGI时代的必由之路。而绝影为加速智能汽车驶入AGI时代,也在“舱-驾-云”三方面打磨出了行业领先的技术与产品解决方案。

在智能座舱领域,绝影将推动其实现自我“叛逆”的进化。惯性认知里,大家认为车机就应该是听话和服从的。叛逆的进化,代表的是积极自主性,而不是对抗。这就是绝影为新一代智能座舱的人机交互打造的积极自主的座舱情感引擎「A New Member For U」,你的家庭新成员!这个家庭成员,有三大特点:“察言观色”“无时不在”“与你心有灵犀”。让我们来感受一下它的魅力。

我们的New Member不是一个听话的工具,循规蹈矩的助手,而是提供主动温暖关怀的“新成员”。比如,它会提醒小朋友少吃糖。他会主动学习,记得你的习惯、你的偏好。理解你,伴随你成长。

「A New Member For U」,它将会成为你的家庭新成员!

绝影的座舱情感引擎New Member背后依靠的是我们的三大技术支撑:分别是车载类人记忆框架、持续运行框架和多模态大模型服务。

那我们先来讲讲车载类人记忆框架。在现实生活中,人和人是通过每一刻发生在你我之间的事情,产生了记忆,让人和人之间产生了情感。不然你就不会记得别人是谁,人与人不会有链接。

汽车也一样。如果没有记忆,就只是一个工具或助手,不会跟你有真正情感上的链接。

真正的智能汽车,必须要有记忆,才能与你心有灵犀!

绝影的汽车类人记忆框架,通过将“临时记忆”和“长期记忆”融合形成“场景记忆”,做到重要信息的高效提取,为特定场景的决策和行动提供依据,赋予智能汽车真正的记忆能力。

我们的车载类人记忆框架,覆盖人、车、物、环境四大类别,总共100多个记忆维度。动态记忆检索,可以做到毫秒级!并且具有自成长的记忆迭代能力!

都说陪伴是最长情的告白,只有一直在你身边,无时不在地为你准备着,才算是一个合格的NEW MEMBER。

绝影业内首创的Always-on持续运行框架,能做到零拷贝传输,并支持持续推理,推理速度高达96 tokens每秒,真正实现实时响应复杂场景。

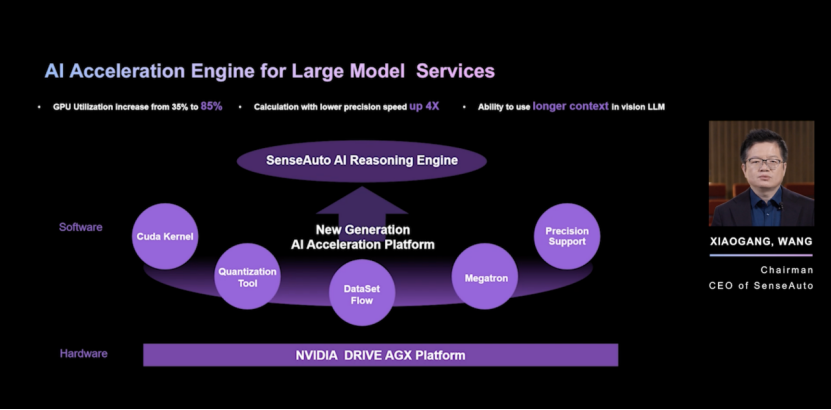

绝影的New Member之所以能取得如此优异的性能,背后得益于绝影基于英伟达软硬件能力开发出的新一代的AI推理加速引擎,它对于提升AI系统的性能和效率至关重要。

绝影联合英伟达在算子开发、模型量化、精度支持等关键技术进行了一系列的深度开发与创新,从而实现GPU利用率从35%提升至 85%、低精度计算速度提升4倍、更长的视觉文本支持等一系列成绩。

下面我来具体展示绝影AI加速引擎的关键技术:

第一个是绝影的Flash-decoding++技术,它可以充分利用空闲计算单元,极大提高解码过程中并行的效率,从而在处理长文本的速度上提高超50%的效果。

第二个是绝影使用先进的Segment Prefill方案研发的一图多问能力,使得多张图片的多个问题尽可能复用先前计算的token,从而大幅度提升系统吞吐效果,将querys延迟性能提升超75%。

第三个是绝影的continue batching方案,在NVIDIADrive AGX端侧芯片上提升系统QPS能力,支持同一时间高效处理多达76个请求。实现用户驾驶体验提升的同时,还确保了行车过程中的安全性和便利性。

在保障以上技术性能领先的过程中,绝影对保障数据隐私的关注是始终不变的重要考虑。在保护用户隐私上,我们有三个原则:数据跟人走、隐私数据不出车、不该说的不说。并且我们还打造了隐私保护体系,确保用户隐私滴水不漏。

如果说,A New Member For U,给智舱以温度,让每一次出行温暖愉悦。那么智能驾驶,会让我们的出行更自由。

绝影最早在2022年提出行业首个端到端架构UniAD,并获得了CVPR 2023最佳论文的认可。这是我们的UniAD技术的实车部署,在复杂路况下也能实现卓越的行驶效果。它不依赖高精地图,也不依赖激光雷达,仅通过7个摄像头的低成本传感器方案,就能够以老司机的实力灵活在各种复杂场景中穿梭自如,获得「类人」驾驶体验。

去年11月,绝影正式发布了基于全球领先端到端UniAD技术打造的,量产端到端智驾方案。这个方案基于NVIDIADrive AGX平台的MIG技术,实现了端到端和传统规则的双系统实时运行,助力更好的对行车过程中的问题进行及时校验和处理。

绝影在此基础上充分发挥双系统协同的作用,设计了首个量产级的、极致安全的端到端智驾解决方案,能在保障整体对复杂场景交互的基础上,保障行车安全。

同时在NVIDIADrive AGX的高精度支持和绝影的方案设计配合下,模型不需要转成整形运算就可以直接运行,避免了量化过程导致的精度损失,提升了开发迭代效率,有效缩短开发周期。目前我们正和中国某头部车厂合作量产UniAD解决方案的量产落地。

同时,我们还研发了新一代融合多模态大模型的端到端智驾方案,依托多模态大模型强大的感知和推理能力,能够更好的应对复杂场景,不断提升整车智能的上限。

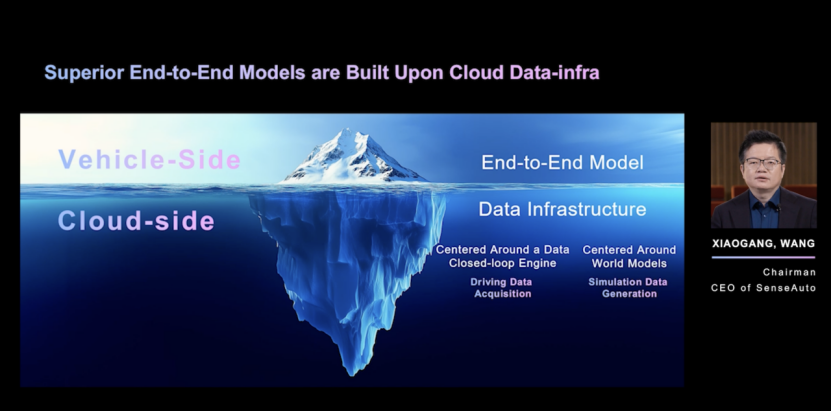

数据驱动的端到端技术的演进,需要海量高质量数据的支撑。当前特斯拉拥有超7百万辆高阶智驾量产车来实现数据回传,中国车厂与特斯拉相比具有一个数量级的差距,想要追赶上必须要通过全新的模式来革新数据基础设施。

绝影依托在自动驾驶和多模态大模型领域的积累,在去年年底绝影日上率先提出用量产实车采集真实数据,用世界模型生成仿真数据,形成双轮驱动,“车云一体”的数据闭环新范式。

基于英伟达云端算力引擎,绝影打造了行业领先的世界模型“开悟”。

“开悟”可以理解真实世界中的“物理法则”和“交通规则”,并在此基础上,能够生成“准确”的场景,具体来说,我们生成的视频,是11V时空一致的,时间最长可以达到150秒,分辨率能够达到1080P;同时,“开悟”生成的场景也是可控的,能细微到“元素级别”,生成场景非常精细,完全满足端到端模型训练和仿真对于数据质量的高要求。

大家可以先看一下我们的世界模型生成的视频。这些视频里面,晴天下周边环境的投影、夜间车辆近光灯的投射,都符合物理法则,真实呈现。这是因为「开悟」通过海量数据学习,懂得了光学原理这些物理法则。同时,「开悟」还学会了交通规则,视频中的车辆刹车时会适当保持车距,在交通信号灯的指示下合理启停。

真实只是基础,世界模型要生成更加准确场景,需要保证多视角的时空一致性。这是「开悟」,行人车辆3D框和时空轨迹,作为精准的输入控制信号,生成的11V视频数据。

同时生成的视角越多,要保持时空一致性就越难,而这11V视角还包括了4个鱼眼摄像头,模型要准确仿真出鱼眼视角的畸变。「开悟」做到了11V,可以灵活满足从1V到11V的各类场景的训练需求。

「开悟」生产数据的效率很高。对比行业平均水平,我们进行了一个测算,基于1张 A100 GPU,「开悟」世界模型平均每天可以生成大约20,000个bundle,相当于10台真值车,或100台路测车的数据采集能力,比得上500台量产车的效率。

此外,「开悟」能够支撑端到端智驾系统迭代的数据闭环,构建“与自车实时互动”的闭环仿真环境。

具体方案是,第一步,是路测新问题的发现,右上角边的视频就是我们在测试中,发现车辆向左并线是更好的选择,但它没有这么做,需要训练优化,我们先用仿真,精准还原了这个场景。

第二步,针对失效案例,生成端到端训练数据。中间部分能看到,我们依赖世界模型中仿真智能体,实现足够多样化和真实的场景推演和专家轨迹生成,生成并线博弈场景数据、专家轨迹数据、对应的训练数据。

第三步,进行端到端仿真迭代验证。我们可以看到,底下的画面是训练后,在相同场景下,系统选择向左并线,通行效率提高。

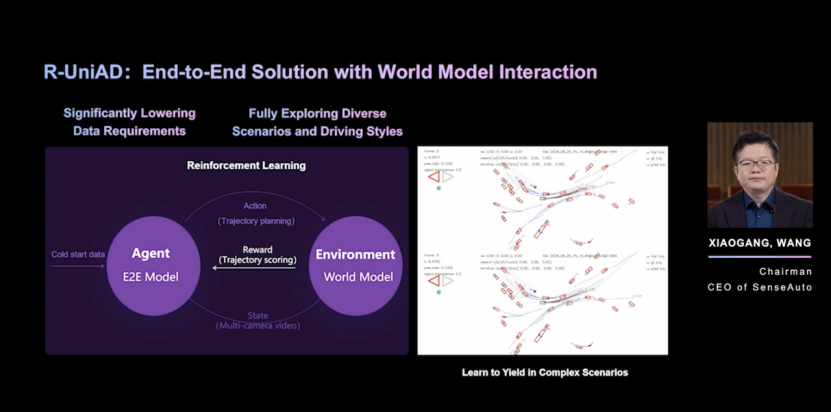

此外,随着近期基于强化学习的大模型训练的思路得到验证,绝影创造性地提出了“与世界模型协同交互的端到端技术路线R-UniAD”。通过“开悟”世界模型生成在线交互的仿真环境,以此进行端到端模型的强化学习训练。基于该范式可以大幅降低端到端模型训练的数据门槛,并在充分探索各种可能性的基础上有望实现远超人类的驾驶表现。

以右边的碰撞场景为例,我们可以看到R-UniAD在复杂交互场景中,通过长思维链有效提升推理效果,最终自行领悟到在该场景下如何进行合理避让,克服了训练前期容易碰撞的问题。

当前,基于英伟达平台,我们领先的舱驾产品,已赋能多家行业领先车企。

座舱方面,我们已于去年底在某国内头部车企上量产首个座舱情感引擎NewMember,并且能力还将快速迭代升级;智驾方面,全球最佳UniAD端到端技术的首款车型也将于今年量产落地,敬请大家期待。

面向未来,绝影将与英伟达联手构建的舱驾融合产品应用生态。在今年,绝影将实现舱驾融合AI域的构建,并进行多元化的舱驾融合产品的研发和打磨。明年,绝影将携手英伟达完成舱驾融合产品在各大车厂的量产落地,并推动智能汽车向朝着超级智能体持续进化,加速智能汽车驶入AGI时代。

绝速影领,智进未来!让我们一起奔赴AGI的旷野!

谢谢大家!

相关文章

- 王晓刚:商汤绝影引领智能汽车进入AGI时代 | GTC 2025

- 商汤绝影首发AI汽车创新产品,世界模型「开悟」全新升级

- 真·端到端自动驾驶、多模态场景大脑、全新3D交互!商汤绝影系列原生态大模型即将亮相2024北京车展

- 商汤绝影高速智驾方案交付,助力哪吒高速领航辅助驾驶体验升级

- 近30款合作车型集中亮相上海车展,商汤绝影打造智能汽车量产落地新范式

- 以“科技”畅享生活之美,商汤绝影助力广汽传祺打造极“智”懂你的智能车舱

- 牵头制定汽车数据脱敏团体标准,商汤绝影为行业发展“保驾护航”

- 商汤绝影“智”迎临港新片区三周年,让自动驾驶走进百姓生活

- 商汤绝影:中国自动驾驶行业的「扫地僧」

- 打造有趣、有温度驾乘体验,商汤绝影助力本田中国全新纯电品牌“e:N”系列新车发布

- 商汤绝影全栈亮相广州创交会,首发车舱乘员健康检测功能

- 商汤绝影智能汽车平台将赋能一汽南京,加速新一代智能汽车量产