浪潮信息赵帅:开放计算创新 应对Scaling Law挑战

2024-08-15 14:12:45爱云资讯7920

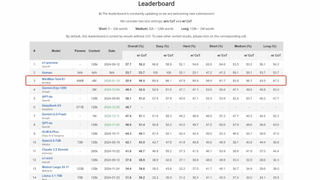

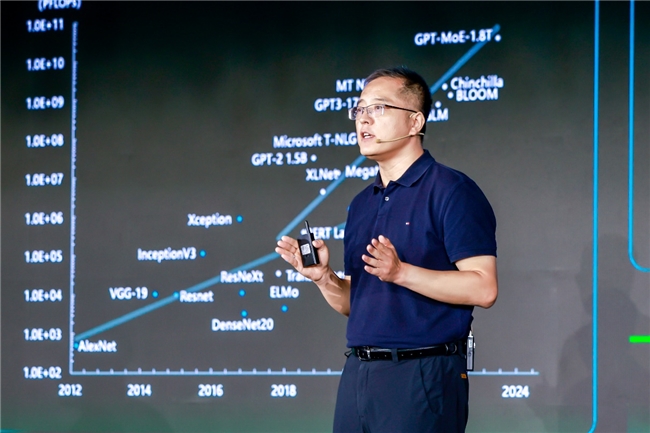

日前在2024开放计算中国峰会上,浪潮信息服务器产品线总经理赵帅表示,智能时代,开源模型和开放计算激发了人工智能产业生态的创新活力,面对大模型Scaling Law带来的AI基础设施Scale up和Scale out的挑战,数据中心需要以开放创新加速算力系统、管理和基础设施的全向Scale进程,推动AI产业的创新发展。

开源开放推动人工智能创新与算力生态的全面发展

生成式人工智能的飞跃式进步正在加速智能时代的到来,数据中心基础设施面临全方位创新,将越来越依赖更加广泛的全球化开放协作,加速AI技术创新与应用,共同构建一个充满创新活力的智能世界,而激发人工智能创新活力,开源开放是核心和源泉。

模型开源激发人工智能创新活力。随着开源大模型能力的不断增强和开源生态的持续壮大,带动模型、应用到产业的全面发展,三分之二的基础模型选择开源,超过80%以上的AI项目使用开源框架进行开发,开源模型的下载量突破3亿次,并衍生出超过 3万个新模型,Llama 3.1、通义千问、源2.0等开源大模型成为人工智能创新的驱动力。

硬件开放完善人工智能算力生态。人工智能带来指数级增长的算力需求,全球已有上百家公司投入新型AI芯片的研发与设计,百花齐放的算力芯片需要统一的算力平台才能快速推向市场,实现落地。开放加速规范OAM的出现大大加速多元算力芯片的适配兼容过程,大幅降低资源投入,使算力部署和迭代提速,支撑上层大模型和AIGC应用的快速迭代成熟。目前,90% 高端AI芯片基于OAM规范设计,去年浪潮信息刚刚发布的基于OAM规范的开放加速计算平台NF5698G7与多款主流AI加速芯片适配兼容,基于OAM的智算产业生态圈日趋完善。

我们可以看到,AI时代,算力正在呈现出多元化的发展趋势。为应对AIGC、云计算、大数据等应用复杂且不断变化的计算需求,不仅仅是GPU,CPU、FPGA、ASIC等芯片也在朝着更加多样化和专用化的方向发展。而且无论是手机、电脑、边缘设备、CPU通用服务器、加速服务器都具有了AI计算的能力,可以说一切计算皆AI,AI算力已经深入到千行百业,渗透进每一个计算设备里。面向人工智能的算力范式不断革新,基于CPU的通用服务器不仅要承载大数据、关键计算、科学计算外,也要承担AI应用的重要任务,这也是CPU通用服务器的重大机遇。

但随着应用范式的多样化,目前x86、ARM、RISC-V等不同架构的CPU处理器百花齐放,仅中国,就有10多种CPU处理器,不同CPU协议标准不统一,同时为了更好的适合AI推理高并行的计算特点,CPU总线互联带宽、内存带宽及容量也需要特别优化,使得系统功耗、总线速率、电流密度不断提升……多种因素叠加之下,硬件开发、固件适配、部件测试资源等时间激增,给算力系统设计带来巨大挑战。

为了缩短从芯片到算力系统的转化时间,给用户提供更快、更好的算力支撑,CPU端也亟需构建智算时代的CPU统一底座, 能够兼容不同芯片厂商、多代产品。2024开放计算中国峰会上,开放算力模组(OCM)规范正式启动,首批成员包括中国电子标准院、百度、小红书、浪潮信息、联想、超聚变、英特尔、AMD等机构和企业。

全新的开放算力模组OCM规范,旨在建立基于处理器的标准化算力模组单元,通过统一不同处理器算力单元对外高速互连、管理协议、供电接口等,实现服务器主板平台的深度解耦和模块化设计,兼容不同架构的多代处理器芯片,方便客户根据人工智能、云计算、大数据等多样化应用场景,灵活、快速匹配最适合的算力平台,推动算力产业高质量快速发展。

OCM规范是国内首个服务器计算模组设计规范,产业界上下游伙伴将基于OCM规范,共同建立标准化的算力模组单元,构建开放合作、融合创新的产业生态,为用户提供更多通用性强、绿色高效、安全可靠的算力选择。

以开放创新的全向Scale应对大模型第一性原理

算力、算法和数据是推动人工智能发展的三驾马车,自Transformer架构出现以来,大模型性能与其参数量、计算当量、数据量的协同作用尤为显著,业界称之为大语言模型的第一性原理——Scaling Law。

智算时代,需要用开放的理念来加速算力系统全向Scale,从而应对大模型的Scaling Law。随着大模型能力的持续进化,算法规模和复杂性不断增加、数据量越来越大,算力需求也在不断攀升,需要同时应对单系统性能提升Scale up与多系统大规模扩展Scale out两个方向扩展的挑战,对数据中心基础设施、算力管理、迭代升级等都提出了更高要求。

在算力方面,智算中心需要同时应对两个方向的扩展,分别是强算力支持、一机多芯、多元多模的单机系统Scale up要求和大规模AI组网、高带宽、资源池化的大规模化扩展Scale out要求,以开放加速模组和开放网络实现算力的Scale。UBB2.0开放标准支持更高算力规格的加速卡、可以实现更大的OAM domain互联,未来可以支持8000+ 张加速卡Scale up,突破大模型All to All通信过程中的互联瓶颈。同时,大模型的发展需要更大规模的算力系统,浪潮信息开放网络交换机可实现16000+个计算节点10万+加速卡的Scale out组网,满足加速卡之间的互联通信需求,带宽利用率高达95%+。

在管理方面,需要解决跨平台适配、模块化架构、快速迭代的Scale要求,以开放的固件解决方案实现了管理的Scale。当前,异构算力多元分化,异步迭代,管理接口规范各不相同,导致固件平台分支版本庞大,相互割裂,无法归一,单一企业资源在维护和适配如此众多的分支版本方面捉襟见肘。为解决一系列管理挑战,需要依托于开源社区的开源固件平台,构建原生解耦架构提升可扩展性,建立统一标准的接口规范,支持用户对于自主模块进行定制化,实现标准接口规范下的异步、自主定制迭代,以满足智算时代的算力迭代需求。

在基础设施方面,数据中心面临智能算力扩展的两大Scale挑战:一是GPU、CPU算力提升,单芯片单卡功耗急剧增加,单机柜在供电和制冷上面临着Scale up支撑挑战;同时,Scaling Law驱动GPU规模无限膨胀,达到万卡、十万卡级别,带来了数据中心层级Scale out的支撑挑战,需要开放标准和开放生态将实现基础实施的Scale,满足快速建设、高算力/高能耗支撑要求。采用开放标准、开放生态构建的数据中心基础设施,能更好地匹配智算时代多元、异构算力的扩展和迭代速度,进而支撑上层智能应用的进一步普及。以浪潮信息为例,基于开放标准推出的液冷冷板组件,支撑单机系统内GPU和CPU核心算力原件Scale up扩展;推出模块化、标准接口的120kw机柜,兼容液冷、风冷场景,支撑柜内更大的部署需求;推出基于开放标准的预制化集装箱数据中心,大幅压缩建设周期,其扩展性很好的满足了AI算力系统的Scale需要。

开放计算为数据中心的全向Scale,提供了一个可以迅速传递到整个产业链的“通道”。 目前,开放加速模组和开放网络实现了算力的Scale,开放固件解决方案实现了管理的Scale,开放标准和开放生态实现了基础设施的Scale。开放计算对于智算时代至关重要,需要用开放应对多元算力,用开放促进算力的Scale,基于开放创新构建的全向Scale能力将会成为未来AI基础设施的核心驱动力,加速智算时代的创新,加速人工智能的前行。

相关文章

- 浪潮信息:元脑企智DeepSeek一体机将举办生态伙伴推介体验会

- 维谛技术 X 浪潮信息 | 强化产业合作,共拓液冷AI算力新格局

- 第一份额:浪潮信息存储成功中标运营商备份一体机集采项目

- 亿级数据、千条告警秒级处理!浪潮信息InManage智能管理10万+IT设备

- 企业大模型应用开发提速 浪潮信息发布元脑企智EPAI一体机

- 浪潮信息Infinistor:高效运维引擎,驱动企业数据价值最大化

- 液气换热型液冷数据中心首个技术标准发布,浪潮信息牵头编制

- 浪潮信息:元脑企智EPAI助力金融大模型快速落地

- 阿里云、字节、浪潮信息、英特尔、电标院: OpenBMC是服务器固件大势所趋

- 显著提升万卡GPU训练性能,浪潮信息X400荣获“2024 DPU&AI Networking Awards“!

- 迎接车路云一体化!浪潮信息路侧计算单元RSCU,可在55度正常工作

- 来布科技数保保软件与浪潮信息云峦KeyarchOS完成澎湃技术认证

- 让服务器开机远离飞机起飞!浪潮信息首创3秒智能控温技术,降噪30.4%

- 浪潮信息赵帅:开放计算创新 应对Scaling Law挑战

- 33家区域ISP伙伴与浪潮信息签署战略合作协议

- 金融数据中心最大规模!浪潮信息InManage助力大行10万+IT设备统一管理