腾讯混元文生图开源模型推出小显存版本,仅需6G显存即可运行

2024-07-06 15:07:18爱云资讯68757

7月4日,腾讯混元文生图大模型(混元DiT)宣布开源小显存版本,仅需6G显存即可运行,对使用个人电脑本地部署的开发者十分友好,该版本与LoRA、ControlNet等插件,都已适配至Diffusers库;并新增对Kohya图形化界面的支持,让开发者可以低门槛地训练个性化LoRA模型;同时,混元DiT模型升级至1.2版本,在图片质感与构图方面均有所提升。

模型易用性再提升,个人电脑可轻松运行

基于DiT架构的文生图模型生成图片质感更佳,但对显存的要求却非常高,让许多开发者望而却步。这也是新版本Stable Diffusion模型无法快速普及的原因之一。

应广大开发者的需求,混元DiT推出小显存版本,最低仅需6G显存即可运行优化推理框架,对使用个人电脑本地部署的开发者非常友好。经过与Hugging Face合作,小显存版本、LoRA与ControlNet插件,都已经适配到Diffusers库中。开发者无需下载原始代码,仅用简单的三行代码仅可调用,大大简化了使用成本。

同时,混元DiT宣布接入Kohya,让开发者可以低门槛地训练专属LoRA模型。

Kohya是一个开源的、轻量化模型微调训练服务,提供了图形化的用户界面,被广泛用于扩散模型类文生图模型的训练。用户可以通过图形化界面,完成模型的全参精调及LoRA训练,无需涉及到代码层面的细节。训练好的模型符合Kohya生态架构,可以低成本与 WebUI 等推理界面结合,实现一整套“训练-生图”工作流。

此外,腾讯宣布混元文生图打标模型”混元Captioner“正式对外开源。该模型支持中英文双语,针对文生图场景进行专门优化,可帮助开发者快速制作高质量的文生图数据集。

相比起业界的开源打标模型,混元Captioner模型能更好的理解与表达中文语义,输出的图片描述更为结构化、完整和准确,并能精准识别出常见知名人物与地标。模型还支持开发者自行补充和导入个性化的背景知识。

混元Captioner模型开源之后,全球的文生图研究者、数据标注人员,均可使用混元Captioner高效地提升自身图像描述质量,生成更全面、更准确的图片描述,提升模型效果。混元Captioner生成的数据集不仅能用于训练基于混元DiT的模型,亦可用于其他视觉模型训练。

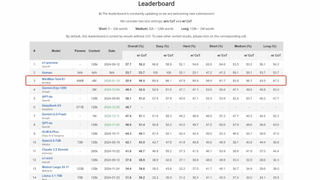

众多开发者关注,成最受欢迎国产DiT开源模型

在提升模型易用性的同时,腾讯宣布混元文生图打标模型”混元Captioner“正式对外开源。该模型支持中英文双语,针对文生图场景进行专门优化,可帮助开发者快速制作高质量的文生图数据集。

相比起业界的开源打标模型,混元Captioner模型能更好的理解与表达中文语义,输出的图片描述更为结构化、完整和准确,并能精准识别出常见知名人物与地标。模型还支持开发者自行补充和导入个性化的背景知识。

作为首个中文原生DiT开源模型,混元DiT自全面开源以来,一直持续建设生态。6月,混元DiT发布的专属加速库,可将推理效率进一步提升,生图时间缩短75%;并进一步开源了推理代码;发布LoRA和ControlNet等插件。于此同时,模型易用性大幅提升,用户可以通过Hugging Face Diffusers快讯调用混元DiT模型及其插件,或基于Kohya和ComfyUI等图形化界面训练与使用混元DiT。

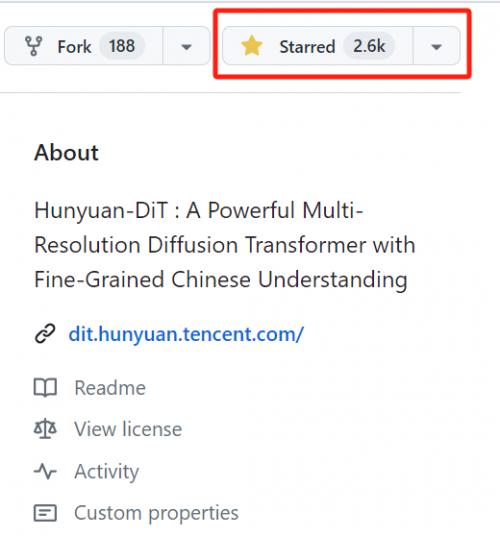

目前,在众多开发者的支持下,混元DiT发布不到2个月,Github Star数已经超过2.6k,成为最受欢迎的国产DiT开源模型。

相关文章

- DeepSeek 从热潮到应用,腾讯云携手行业专家共探 AI 下一步

- 座无虚席!前沿技术议题吸引全球游戏开发者,腾讯游戏安全ACE亮相GDC2025

- 贝锐与腾讯云宣布战略合作升级,共同推进国产技术及全球市场布局

- 腾讯云与拈花湾文旅战略合作升级 共探数字化全域经营体系

- 老乡鸡与腾讯智慧零售达成战略合作:瞄准数智化

- 德适生物与腾讯云达成战略合作 共筑医学影像智能新基建

- 腾讯七年累计研发投入3403亿,AI战略提速重塑全域业务

- 六度人和携手腾讯云接入DeepSeek, 客户意向转化率提升30%

- 深圳印发重磅新政《行动计划》,三星/腾讯/微美全息强化AI优势构筑护城河

- 凡泰极客与腾讯云传媒达成战略合作,赋能传媒行业数字化跃迁

- 腾讯iOA荣获2024年度赛可达优秀产品奖及ATT&CK安全能力奖

- AI漫画翻译成本降低90%!快看漫画携手腾讯云接入DeepSeek

- 腾讯企点客服接入DeepSeek大模型,实现问答质量和客户满意度双重提升

- 腾讯云助力天润融通接入DeepSeek,客服机器人独立接待率提升15-20%

- 腾讯安全市占率领跑!艾瑞咨询最新威胁情报市场报告出炉

- 京东&腾讯视频首款定制百吋电视即将开售 海量超高清片源免费看