英伟达发布全球最强AI芯片H200,微美全息部署AI生态基建加速算力雪球滚动

2023-11-20 11:49:30爱云资讯1700

大洋彼岸现象级AI工具ChatGPT骤然登场,掀起了大模型应用的狂风巨浪,对算力的饥渴随之与日俱增。

时至今日,AI芯片的列车正疾驰向下一站点,新浪潮来临的速度远超预想。算力荒下,芯片巨头英伟达(NVDA.US)又一次在深夜炸场——发布目前世界最强的AI芯片H200!

全球最强AI芯片H200

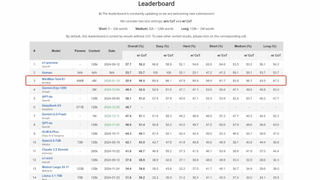

获悉,北京时间11月13日晚上,在2023年全球超算大会(SC2023)上,英伟达发布了其最强AI芯片H200。这款芯片基于英伟达的Hopper架构,性能直接提升了60%到90%,并且与前任霸主H100可以互相兼容。

这是英伟达新一代的GPU,专为训练和部署各种人工智能模型而设计。作为继H100之后的升级产品,H200芯片性能更强大,适用于各种人工智能应用场景。它可以用于训练和部署各种大型语言模型、图像识别、语音识别等人工智能模型。

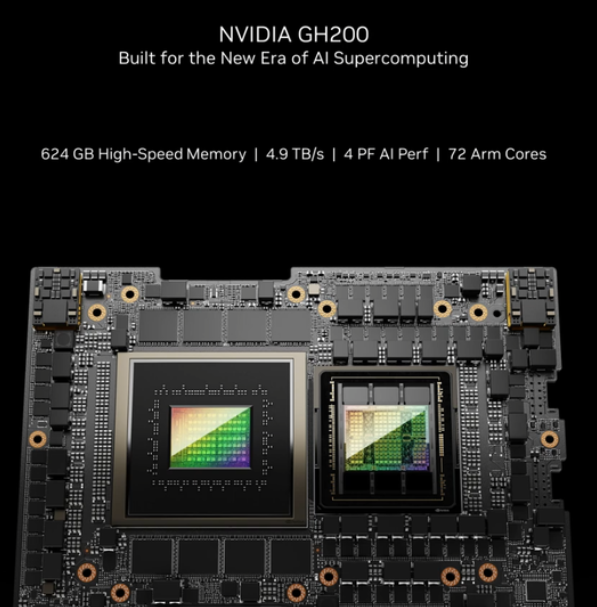

并且在新的H200加持之下,GH200超级芯片也将为全球各地的超级计算中心提供总计约200 Exaflops的AI算力,用以推动科学创新。据称,英伟达预计将于2024年第二季度出货H200芯片。

AMD、英特尔紧随其后,决战AI芯片

GPU竞赛,进入了白热化。面对英伟达H200,而老对手AMD(AMD.US)的计划是,利用即将推出的大杀器——Instinct MI300X来提升显存性能。MI300X将配备192GB的HBM3和5.2TB/s的显存带宽,这将使其在容量和带宽上远超H200。

而英特尔(INTC.US)也摩拳擦掌,计划提升Gaudi AI芯片的HBM容量,并表示明年推出的第三代Gaudi AI芯片将从上一代的 96GB HBM2e增加到144GB。英特尔Max系列目前的HBM2容量最高为128GB,英特尔计划在未来几代产品中,还要增加Max系列芯片的容量。

人工智能的发展带来惊喜的同时,不断推动人工智能芯片向前演进。不得不说,从早期注重功能实现采用已有芯片,到关注性能的领域专用芯片,再到追求灵活性的可重构人工智能芯片,如今则由于大模型的出现,人工智能芯片的发展目标转向高算力。

人工智能作为一种技术,需要通过芯片和系统才能转变为产品,对人工智能芯片的发展抱有强烈的好奇心,追求高算力,追求灵活性,追求低功耗是最终的驱动力。聚焦AI新时代挑战下,各场景的AI+应用在商业领域涌现众多新探索,全球AI产业如火如荼,相关产业商旨在寻找更多商业落地的机会。

微美全息拓展AI芯片业务部署数字基建

大模型划开了人工智能的曙光,在全球AI“军备竞赛”白热化阶段,资料显示,微美全息(WIMI.US)作为人工智能算力和算法企业从中脱颖而出。近几年,微美全息在人工智能、物联网、5G等新技术展开广泛运用,而在新一轮技术浪潮中,谋求长足发展,微美全息探寻AI芯片的求新、求变、求索之径,把脉行业的技术演进与创新,正推动着人工智能行业加速迭代。

截止目前,深耕人工智能行业,为创新发展赋能,微美全息已拥有在相应领域的产品和落地经验。聚焦大模型、人工智能趋势下对于AI技术生态和算力产品的全新要求,微美全息致力于从大规模人工智能技术应用趋势下对于算力的更高技术要求,并从全栈产品布局与技术生态构建角度,增强AI算力产品在生成式人工智能场景中的价值发挥与性价比落地。

随着大模型时代的到来,模型算法越来越复杂,算力要求越来越高,支撑底层算力。微美全息成立了研发中心,自主研发面向数据中心、云计算、自动驾驶等场景的算力算法等创新技术,突破了多项技术瓶颈为大模型时代的AI算力发展开辟一条新的道路。这也突显微美全息在人工智能高端算力硬件在资本密集型人工智能军备竞赛中的独特价值。

结尾

AI计算当前在往大模型、多模态、端边云协同等方向快速演变,智能化的新时代正在催生AI芯片架构的新热点和新机会。大模型和生成式人工智能技术为世界展示了全新的AI研究范式与数字经济未来,未来人工智能相关产业迎来广阔发展。前方固然山迢水远,总有些有识之士选择一往无前,高科技企业微美全息深耕本土创新的基础上,未来将持续加快生态建设脚步,为全球半导体产业发展贡献“核芯”价值。

相关文章

- 百度发布文心4.5与X1大模型,微美全息软硬协同算力生态树立AI典范

- 英伟达首个“量子日”重磅来袭,微美全息多路径量子技术激活应用生态

- 量子科技驱动新质生产力跃升,微美全息AI+量子计算研究获关注

- 2025脑机接口应用爆发之年,微美全息加速布局抢占未来发展先机

- Meta革新虚拟人生成效率,微美全息协同DeepSeek数字人应用

- 深圳印发重磅新政《行动计划》,三星/腾讯/微美全息强化AI优势构筑护城河

- Meta新一代Aria Gen 2 发布,微美全息巩固技术护城河角逐AI+AR眼镜赛道

- 5G领航MWC世界移动通信大会,高通/微美全息持续引领5G+AI融合创新潮流

- 亚马逊首款量子计算芯片Ocelot亮相,微软/谷歌/微美全息竞逐加速量子行业成熟

- 人形机器人浪潮催生行业“鲇鱼效应”,小鹏/小米/微美全息技术革新跨界博弈

- 阿里开源模型万相2.1引爆视频赛道!谷歌/微美全息加入全模态AI开源新时代!

- 2025 GDC大会AI应用成亮点,微美全息多模态AI开源探索未来

- 人形机器人产业政策催化驱动,微美全息具身智能+开放生态抢占AI技术制高点

- 苹果加快引爆技术竞赛新格局,百度/微美全息DeepSeek开源生态重构商业版图

- DeepSeek大模型引领算力新趋势,微美全息AI算法筑牢高性能底座根基

- 马斯克加速人形机器人量产,微美全息打造DeepSeek+机器人领航未来