高效管理海量数据!忆联SSD为分布式块存储提供极致性能

2023-10-17 14:11:05爱云资讯1089

近年来,为满足大规模的存储应用需求,分布式存储成为云环境下存储底座构建的重要选择,相较于传统集中式存储方案的可靠性、安全性以及数据利用率较低,分布式存储具有易扩展、高性能、高性价比、支持分级存储、多副本一致性及存储系统标准化等优势。

块存储作为分布式存储的一部分,主要为计算集群虚拟机、容器提供弹性卷服务,而弹性卷 EVS 则是当前云业务平台最核心的存储服务,对存储性能要求极高,基于此,各大云厂商基本采用全闪化形态部署。

Ceph 则是当前业界应用最广泛的开源分布式存储软件,凭借高扩展性、高性能、高可靠等特点,同时支持块存储、文件存储及对象存储接口,已成熟应用于云计算的 IAAS 平台。为更好地助力分布式块存储系统性能及可靠性的提升,忆联在 Ceph 平台下开展实测,本文为此次的测试结论。

一、Ceph 简介

Ceph 是一个统一的分布式存储系统,可提供较好性能、可靠性和扩展性,是面向云计算领域重要的底层存储系统,已在国内运营商、政府、金融、互联网等多个行业落地应用。

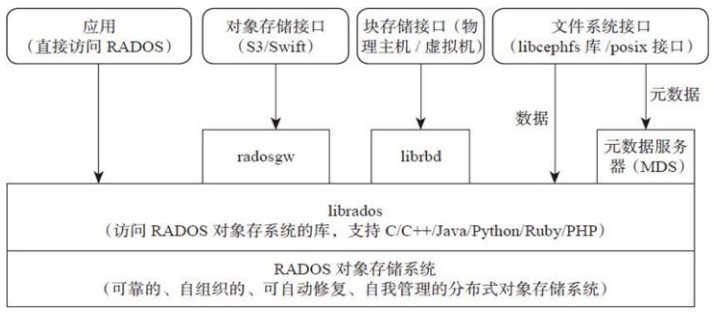

图 1:Ceph 技术架构图

Ceph 主要分为应用接口层、存储基础接口层、存储对象层。接口层主要负责客户端访问,分为本地语言绑定接口、块存储设备接口和文件系统接口,展现了 Ceph 统一性。

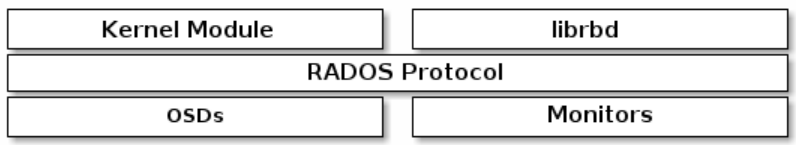

在 Ceph 块存储系统中,数据以块的形式存在卷里,块为应用程序提供大存储容量,可靠性和性能都更高,卷可映射到操作系统中,由文件系统层控制。Ceph 块存储系统引入的 RBD(Ceph 块设备)协议为客户端提供了高可靠、高性能、分布式的块存储,同时 RBD 也支持其他的企业级特性,例如完整和增量式快照,精简的配置,写时复制( copy-on-write)式克隆,以及全内存式缓存等,从而大大提高了系统的性能。

图 2:Ceph 块存储组件

二、忆联 Ceph 存储方案验证

1.验证环境

本次验证硬件配置

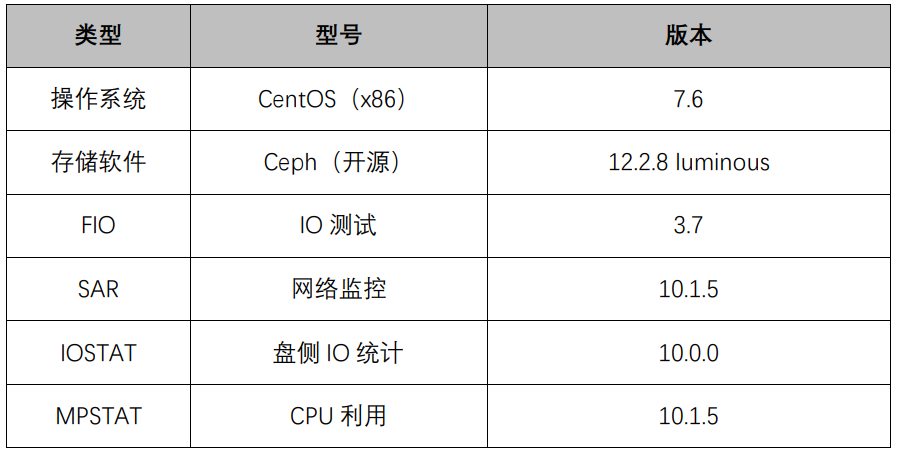

1.2本次验证软件配置

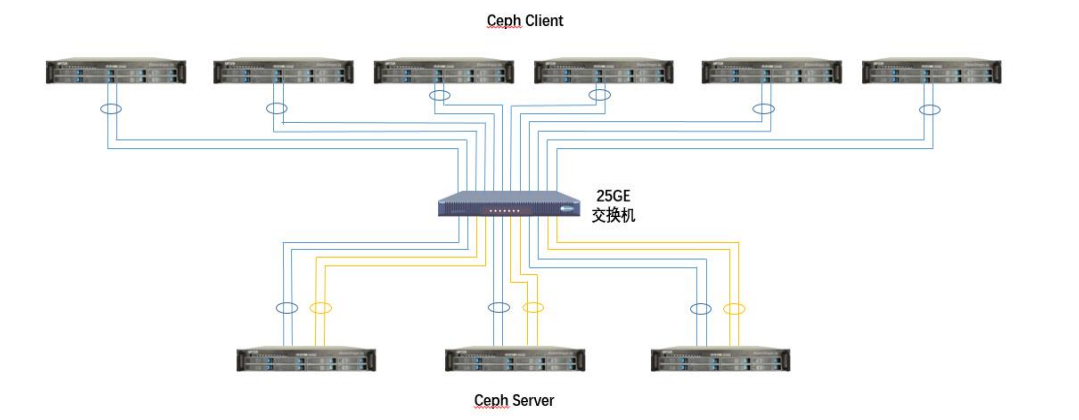

1.3本次验证组网规划

图 3:Ceph 组网规划架构图

2、验证方法

步骤 1:创建 RBD pool 和 RBD 卷。配置参数 osd_pool_default_size 确定 RBD Pool 池的副本数,2 表示两幅本,3 表示三副本,根据实际副本数需求,将该配置项添加到 ceph.conf 中即可。另外根据规划,需要创建 60 个大小为 100GiB 的 RBD 卷进行 IO 测试。

步骤 2:下发 IO 测试前,需对服务器和客户端的 IO、CPU、网络进行监控,每 2 秒采集一次数据。

步骤 3:在 6 个客户端上同时对 60 个 RBD 卷下发 IO,每个客户端均需绑核,即每个 fio 绑定不同 cpu 核。

步骤 4:完成 IO 测试后,需关闭服务端和客户端的 IO、CPU、网络进行监控。

步骤 5:测试完成后,需汇总所有客户端 fio 的 BW、IOPS、平均时延,汇总对应的监控数据。对于 BW 和 IOPS,累加各 FIO 对应结果即可;对于平均时延,累加之后需求平均值。

3、验证结果

本次在 Ceph 场景下验证结果如下:

忆联 UH8 系 SSD 在随机读及顺序读下的表现。

图 4:Ceph 场景下忆联 UH8 系 SSD 读性能

从图 4 可以看出,在 Ceph 分布式存储系统下,不论是二副本还是三副本,忆联 UH8 系 SSD 的读性能基本持平。在时延方面,二副本与三副本趋势基本一致,1QD 至 32QD 间较为稳定,在 32QD 后时延明显增加。

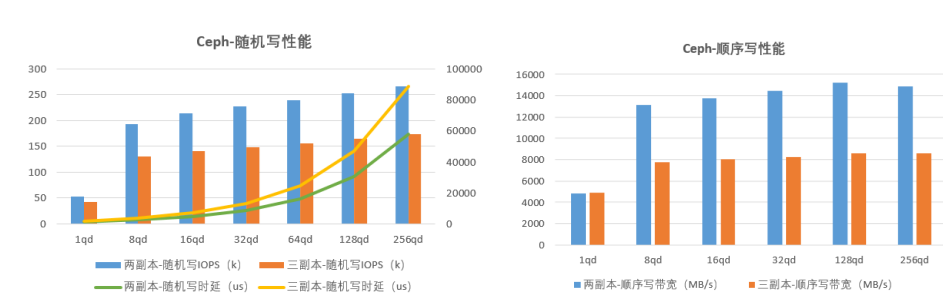

忆联 UH8 系 SSD 在随机写及顺序写下的表现。

图 5:Ceph 场景下忆联 UH8 系 SSD 写性能

如图 5 所示,不论是在随机写还是在顺序写业务下,二副本写性能远高于三副本性能,主要是由于副本复制带来的网络及存储开销,造成三副本写带宽及写 IOPS 下降明显。在总体时延表现上,二副本明显优于三副本。在时延变化趋势上,二副本与三副本基本一致,皆在 32QD 后有比较显著的上升。

忆联 UH8 系 SSD 在混合读写场景下的表现

图 6:Ceph 场景下忆联 UH8 系 SSD 混合读写性能

从图 6 可以看出,在 4K 7:3 混合读写业务场景下,从 16QD 起,二副本 IOPS 性能优于三副本。在时延整体表现上,二副本低于三副本,但在时延变化趋势上,二副本与三副本基本一致,时延从 32QD 起,明显上升。

小结: 从 Ceph 读、写、混合读写业务场景的实测数据中,可以看到忆联 SSD 整体表现优秀,可为 Ceph 环境提供极致存储性能。在时延上,忆联 SSD 在 32QD 及以下场景中,表现亮眼,可获得更佳的时延体验。

智能多流降 WA,有效提升 SSD 寿命

为更好解决读写机制带来的写放大而造成的 SSD 性能损耗及使用寿命缩短,忆联推出 SSD 的智能多流特性,通过智能冷热数据分类算法,有效提高 GC(垃圾回收)时的效率,减少写放大,提升 SSD 性能。

图 7: Ceph 场景下智能多流特性测试

在 Ceph 方案中,基于标准 JESD 219 业务模型,针对 SSD 分别开启、关闭智能多流进行写放大测试,通过图 7 对比验证结果可以看到忆联智能多流(IMS)开启后,SSD 写放大降低 20%+,极大提升了 SSD 寿命。

本次验证证明了忆联 SSD 在 Ceph 分布式存储系统中的稳定性能,可有效支撑 Ceph 的存储需求,为 Ceph 提供始终如一的高性能,成为软件定义存储解决方案最优的选择。同时,忆联 SSD 独有的智能多流技术可降低分布式存储场景下 SSD 写放大,提升 SSD 寿命,帮助用户减少总体 TCO。对于 Ceph 分布式存储系统而言,忆联 SSD 是一个可真正做到高性能、高可靠、低成本的存储解决方案。

相关文章

- 圆周率智能发布全新嵌入式离线地图引擎:小存储大能量赋能多场景智能导航

- 突破存储瓶颈!铁威马D4-320U硬盘柜高效备份与扩展

- Supermicro推出搭载NVIDIA超级芯片的新型千兆全闪存存储服务器

- 容声冰箱AWE发布百种蔬果养鲜数据,重新定义食材存储标准

- PTM模式下的存储定制,上海江波龙开创新未来

- 得一微:主控芯片设计重塑存储价值

- 铠侠参展CFMS 2025:布局下一代先进存储,持续助力高能AI

- Solidigm高密度方案解决数据中心存储难题,赋能AI创新发展

- DeepSeek开源3FS背后:软硬一体的专用AI存储系统

- 西部数据推出大容量存储方案,赋能NAS用户、创意专业人士与内容创作者

- ExponTech WDS:为通联支付打造灵活高效的存储解决方案

- 部署DeepSeek-R1全参数模型,云彣48GB大容量存储方案成关键

- NetApp革新ASA A系列块存储解决方案,全面推动智能数据基础设施升级

- 得瑞领新邀您共赴CFMS|MemoryS 2025峰会:以创新重塑存储产业价值新未来

- NAS随手存储,备份就选铁威马F8 SSD Plus

- 自动释放本地存储空间,华为云空间助你轻装迎接新学期