左手调度平台右手算力云,青云QingCloud打出AI算力普惠组合拳

2023-10-01 06:36:50爱云资讯880

IT行业变化太快,不变的唯有变化。如今,在OpenAI的直接带动或刺激下,大模型已经成为企业间竞争的新焦点,这不仅加速了更多大模型的开发与训练,还促使企业在其原有的产品中融入大模型的能力,以便在新的范式转换和技术进步中抢占先机。

“对于青云来说,AI时代将是一个全新的机遇,它将会带来长达10年、比过去10年更大的市场需求和机会。”青云科技总裁林源如是说。而在AI大模型这一轮技术进步中,支撑人工智能所需的算力自然也成为关注的焦点。基于对AI算力需求的洞察,9月19日青云全新发布青云AI算力调度平台、青云AI算力云等产品与服务。

我国AI算力发展迎来黄金期

随着AI大模型的发展,算力的重要性日益凸显。以ChatGPT为例,根据相关调查数据,ChatGPT的总算力消耗约为3640PF-days,需要7到8个投资规模为30亿、计算能力为500P的数据中心才能支持其运行。值得注意的是,AI训练任务中的算力增长速度极快,每3.5个月就会翻一倍。

在算力需求提升的同时,算力已成为推动数字经济发展的核心力量。《中国综合算力指数(2023年)》的最新数据显示,截至2023年6月底,我国算力总规模已经达到了197EFLOPS,全国在用数据中心机架总规模超过760万标准机架,位列世界第二。我国算力总规模近五年年均增速近30%。

特别是AI大模型等技术的发展,引发了AI算力需求的进一步增长。在当前的算力规模下,智能算力规模占整体算力规模的比例已经提高到了25.4%,同比增长达到了45%,比算力规模整体增速高出了15个百分点。林源表示:“在AI的刺激下,算力需求呈现出飞速增长的趋势,相较于传统的CPU时代的需求,它已经增长了10倍、100倍甚至更多。”

一大批重大工程项目,也进一步推动了算力产业的快速发展。其中,超算中心和智算中心的建设是重要举措之一。自2009年以来,科技部批准了14所国家超级计算中心,分布于天津、济南、无锡、昆山、深圳等地。同时,各地也积极投入智算中心的建设之中。据公开报道,截至今年8月15日,全国至少有30座城市已经建成或正在建设智算中心,这还不包括企业自主建设的智算中心。

AI驱动下,智算中心面临哪些挑战?

AI算力产业的发展既是机遇又是挑战。

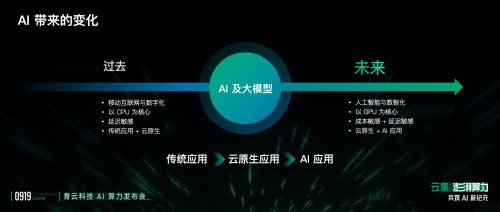

林源认为,AI和大模型是重大生产力的变革,在这场技术推动的市场变革中,客户需求、算力需求、应用需求和底层架构都在发生变化。在过去十年,无论是面向C端的移动互联网还是面向B端的数字化,主要基于CPU进行应用革新。然而,随着AI的普及,几乎所有应用都需要拥抱AI技术或被AI改造,使得GPU的需求量增加。

不仅如此,在东数西算的趋势下,未来AI应用将在追求效率的同时,更加注重成本效益,从而推动算力从延迟低的东部沿海地区向价格更便宜的西部地区发展,未来算力分布将更加分散。此外,随着AI和云原生技术的不断发展,客户业务将更加复杂,业态将更加丰富,对技术和平台的挑战也将越来越多。

尤其是在智算中心建设和运营过程中,其设计合规化如何考量,超算、智算、通算等多元算力如何做到统一调度,传统应用、云原生应用、AI应用如何同时兼顾,如何支持异构CPU/GPU,如何提供高效网络与存储,如何实现高效地运维与运营等,都是需要考虑的问题。可以说,智算中心建设后的运营成为关键挑战。

如何充分应对这些挑战?在笔者看来,未来算力将像水、电一样成为公共资源,随着算力规模的扩大,算力调度和交易将会被用于解决算力的供需问题。

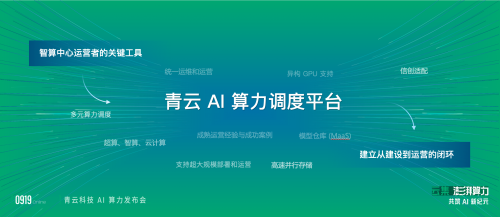

九大关键能力,解读AI算力调度平台

基于自身经验与实践,青云科技也给出相应的答案——AI算力调度平台,并为行业提供了一份可参考的范式。青云科技产品经理苗慧表示:“AI算力调度平台作为算力中心建设运营的新模式,目的是像管理本地资源一样,管理AI基础设施,提供多元算力调度,提供智能化的算力调度,保证算力能快速建立起来。”

据悉,青云AI算力调度平台正在根据多种芯片支持、全生命周期管理、多种AIGC模型一站式交付、多元计算能力等进行优化与研发,为算力中心提供更好地支持和服务。

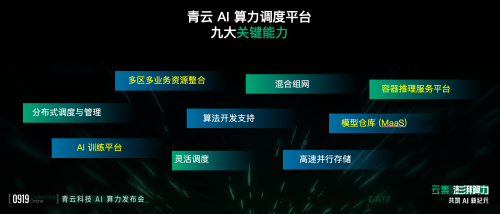

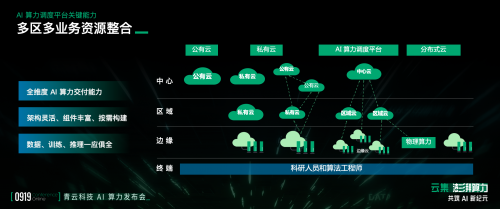

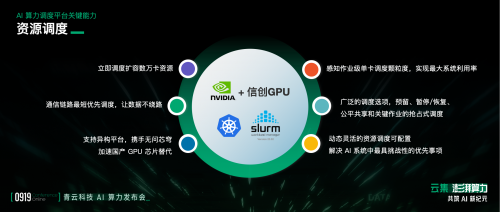

苗慧透露,青云AI算力调度平台具备九大关键能力,分别为多区域多业务资源整合、混合组网、容器推理服务平台、分布式调度与管理、算法开发支持、模型仓库(MaaS)、AI训练平台、灵活调度、高速并行存储。

在多区域多业务资源整合方面,青云科技通过多区域、多中心、多Zone的形式纳入到云平台上统一管理。在进行资源调度时,青云科技采用就近原则对后端服务器、资源组设置路径标签,以供用户就近调用。

在资源调度方面,青云科技可以实现立即调度扩容数万卡资源、通信链路最短优先调度、支持异构平台、感知作业级单卡调度颗粒度、广泛的调度选项,以及动态灵活的资源调度等关键能力。苗慧表示:“青云所有的节点、服务器、存储设备都有相应的路径标签,可供用户设置路径距离,并且青云通过该算法,计算最短通信链路,以确保两个节点在一个交换机内,减少数据的传输损耗。”

在AI训练方面,青云提供了一个在线训练平台,专注于将高性能计算和GPU卡等资源集成起来。在这个专属的环境中,青云提供了GPU服务器在线申请和构建集群的功能,所有的网络和环境都可以一键生成。此外,青云还针对行业内常用的模型和小工具进行了集成,使用户能够更方便地进行训练和应用。

林源认为,AI算力调度平台是智算中心运营者的关键工具,将帮其建立从建设到运营的闭环。林源透露,青云AI算力调度平台已经在国家超算济南中心成功应用。

依托生态的力量,打造AI算力云

在会上,青云还发布AI算力云产品。林源介绍:“AI算力云是以青云为主,以生态联合的方式,对外运营的AI算力服务。”青云发布的AI算力云为何要借助生态的力量?又是如何运营AI算力云的?这是有一定的原因的。

传统模式下,大厂喜欢从底层IDC到软件、PaaS都进行自建、自投和自营,但这种模式会导致研发成本高昂,压力增大。而在AI时代,每一层的成本都比过去更高,例如大模型的研发需要大量人力、算力和时间,同时还需要成熟的算力调度平台和IDC建设。因此,虽然一个大厂可以选择从上到下都自己干,但这样做会非常吃力和费劲,并且成本也会更高。

相比传统模式,青云打造的AI算力云有其一定的优势:从客户的角度来看,他们需要一个完整的解决方案,包括有机房、算力、调度平台、模型驱动、模型、Model Service和上面的应用;从供应商的角度来看,每层都需要专业的技术和长时间的积累和巨大的投入。

林源认为,在AI领域,一定会出现巨头,但这些巨头不应该是一家独立的公司,而应该是一个一个良好的生态合作体系,需要各家公司协同合作,共同推动AI技术的进步和发展。

“青云AI算力云服务的定位是一个开放的生态同盟,所以青云在集结志同道合的合作伙伴,通过‘同盟’的方式一起运营AI算力云服务。”林源如是说。青云也将通过开放的、成熟的、可运营的一个AI算力调度平台,通过自营、合营乃至支撑第三方运营的方式,与生态同盟一起贡献AI Cloud。据悉,青云AI算力云能够提供算力资源、存储资源,以及镜像仓库、容器推理、高速IB网络等能力。

青云认为,未来AI时代,企业一定是通过算力服务、算法和模型、高价值的数据来实现智能化,这也是AI生态体系的价值所在。青云AI算力云服务主要围绕AI算力基础设施的生态共享、AI算力大模型的资源整合以及AI数据资源的生态整合。

据笔者了解,青云AI算力组件生态已有英特尔、英伟达、AMD、中科曙光等;AI模型生态已有紫东太初2.0、商汤、智谱清言等;AI算力服务生态已有国家超级计算济南中心、清华大学电子工程系智算中心、中国电信等;AI应用场景也已囊括金融、交通、制造业、能源、自然资源等行业领域。

写在最后

在AI大模型的驱动下,AI算力未来的发展也迎来新的机遇和挑战,而躬身入局的厂商势必拿出过硬的“武器”,方能在时代趋势下赢得持续发展的先机。在这个背景下,青云结合自身实践、优势与经验,左手抓AI算力调度平台,右手抓AI算力云,两手抓、两手都要硬,通过在算力运营服务的实力,以及借助生态的力量,不断壮大自己,助力企业实现AI的业务价值。

相关文章

- 青云AI算力云上线万相 Wan2.1-T2V 模型,开启文生视频新体验

- 青云QingCloud KubeSphere 企业版 v4.1.3 发布,管理策略更灵活更安全

- 青云科技 AI 应用开发平台开启公测,一站式构建企业级应用

- 接入DeepSeek大模型!青云科技助力鼎和保险的专属AI助手正式上线!

- 671B 满血 DeepSeek-R1 上线!青云科技一文教你如何创建自己的 AI 应用

- 青云科技参与北京市科委重点项目,助力京蒙算力智能调度

- 青云科技发布 2024 业绩预告,净利润增长 42.43%

- 青云QingCloud入选 CSDN 2024 中国开发者影响力年度榜单

- 青云QingCloud收到中国信通院感谢信

- AI 时代,青云科技与曙光存储携手布局数据航海图

- 青云科技入选“新智榜单”——人工智能应用标杆 TOP100

- 青云科技作为重点厂商入选甲子光年《中国 AI 算力行业发展报告》

- 深度融合华为昇思,青云科技智算通过昇腾兼容性认证

- 青云科技获鲲鹏原生开发认证,共筑金融数字化基石

- 朝阳区金融服务矩阵发布,青云科技作为标杆企业受邀发言

- 青云科技陪伴人形机器人的 AI 训练之旅