对阵ChatGPT们,存算一体超异构突破算力天花板在即

2023-03-23 10:39:55爱云资讯阅读量:796

摘要:国产自主意识爆发,3.14,亿铸率先提出存算一体超异构,引领新一代技术潮流。

AI 3.0时代,国产自主意识爆发

ChatGPT自出世以来,在国内AI界卷起千层浪:

先是百度、科大讯飞等AI大厂纷纷表示自己有着类ChatGPT能力;再是国家发布东数西算一体化算力服务平台,支撑中国人工智能运算平台急需的大算力服务。

而大算力的实现,都需仰仗“大脑”AI芯片。

纵观AI芯片在国内的发展史,我们大致可以将AI芯片国产化分为几个时代。

在AI芯片国产化1.0时代,继Google推出ASIC芯片后,国内寒武纪、灵汐、华为等国内厂商陆续跟上脚步,针对云端AI应用推出ASIC架构芯片。

接着AI芯片国产化进入2.0时代。在看到以英伟达为代表的GPGPU架构在AI算力芯片上有着不错的性能表现后,国内多个厂商例如天数智芯、珠海芯动力、壁仞等纷纷布局GPGPU芯片,主打CUDA兼容,试探着AI算力芯片的极限。

在前两个时代中,国产AI芯片厂商都在竭力顺应时代潮流,前赴后继地跟随国际大厂的步伐,通过研发最新芯片解决AI算力芯片的挑战。

现如今,随着ChatGPT等大模型掀起热潮,我们站在AI芯片国产化3.0时代的门口,面对越发严峻的地缘政治处境,国产芯片厂商自主意识更为强烈,希望能够自发提出芯片解决方案。

例如,国内AI大算力芯片企业亿铸科技,已为中国的AI大算力芯片一次又一次提出先进的解决方案:

先是在2020年,亿铸科技一成立就尝试通过架构创新突破冯·诺伊曼瓶颈,成为首个研发基于ReRAM(RRAM)全数字存算一体AI大算力芯片的企业,为解决国内AI算力尤其是大算力的困局提供了新的方向。

再是今年3.14日,在《电子创新网》“从ChatGPT的角度聊聊存算一体AI大算力芯片”直播中,亿铸科技创始人熊大鹏博士首次提出“用存算一体超异构做AI大算力芯片”的技术思路。

亿铸科技多次提出新解法是因为,种种迹象表明,AI算力难题愈发严重,国产化AI芯片的处境越来越难。

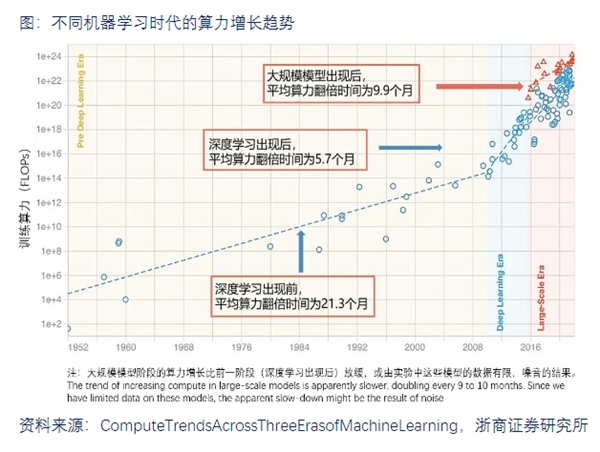

先是算力本身就因摩尔定律失效在加速狂飙,每5-10个月就要翻倍:

(不同机器学习时代的算力增长趋势图源:浙商证券研究所)

到2021年,全球计算设备算力总规模达到615EFlops,增速44%。浙商证券预测,2030年,算力有望增至56ZFlops,CAGR达到65%。而这还是ChatGPT还未降临之时,正常的算力需求预测值。

(全球算力规模及增速图源:浙商证券研究所)

2022年底,ChatGPT来临之后,无疑又将拔高算力的增长曲线:

根据通信世界数据,ChatGPT的总算力消耗约为 3640PF-days (即假如每秒计算一千万亿次,需要计算3640天) ,需要 7-8个投资规模30亿、算力500P的数据中心才能支撑运行。

而这才是参数规模1750亿的GPT-3,除此之外还有参数5620亿的PaLM-E······彼时,算力以及其背后的功耗还能顾得过来吗?

AI算力需求如脱缰的野马,但FPGA、ASIC、GPGPU等芯片本身,已苦于先进制程久矣。据芯粒说表示,目前芯片先进制程升级面临着性能极限、技术极限、成本极限。成本极限具体来说就是,到了5nm以下,建造一座先进制程的晶圆厂动辄需要上百亿美元的投入。

钱是花了,工艺是卷到头了,但能效比提升有限:

传统架构下,由于数据需要频繁地在存储、计算单元间来回跑,随着数据越增越多,“存储墙”、 “能耗墙”、“编译墙”等问题也愈发严重。

现如今,这“三堵墙”已导致大量算力无谓浪费:据统计,在大算力的AI应用中,数据搬运操作消耗90%的时间和功耗,数据搬运的功耗是运算的650倍。

ChatGPT们正提出“极为离谱、不切实际”的算力需求,而芯片们又陷入先进制程升级濒临极限、能效比提升受阻等困境,时代正呼吁着新鲜的血液注入AI大算力芯片。

突破天花板的底气

亿铸科技自发提出的存算一体架构、存算一体超异构计算皆能为AI大算力困局“排忧解难”:

存算一体架构,将存储和计算的融合,能够打破传统架构下的三堵墙,彻底消除访存延迟,并极大降低功耗。同时,由于计算完全耦合于存储,因此可以开发更细粒度的并行性,获得更高的性能和能效。

超异构计算,能够把更多的异构计算整合重构,从而各类型处理器间充分地、灵活地进行数据交互而形成的计算。

简单来说,就是结合DSA、GPU、CPU、CIM等多个类型引擎的优势,实现性能的飞跃:

DSA负责相对确定的大计算量的工作;

GPU负责应用层有一些性能敏感的并且有一定弹性的工作;

CPU啥都能干,负责兜底;

CIM就是存内计算,超异构和普通异构的主要区别就是加入了CIM,由此可以实现同等算力,更低能耗;同等能耗,更高算力。另外,CIM由于器件的优势,能负担比DSA更大的算力。

亿铸科技创始人、存算一体AI 大算力芯片的开拓者熊大鹏博士表示,其好处在两个方面:一是在系统层,能够把整体的效率做到最优;二是在软件层,能够实现跨平台架构统一。

亿铸选择将两大技术结合,即“存算一体超异构”的想法,与苏妈的“系统级创新”不谋而合:在ISSCC 2023,苏妈提出系统级创新概念,即从整体设计的上下游多个环节协同设计来完成芯片性能的提升,并给出使用该概念实现数量级的效率提升案例。

也就是说,若是将存算一体、Chiplet(芯粒)、3D封装等技术同步使用,很有可能带来数量级的效率提升,从而突破性能瓶颈。

亿铸提出这一极具创新度的构想,也是因为其底气十足。亿铸科技拥有实力雄厚的研发、工程及顾问团队:

其核心研发团队成员均为来自国内芯片大厂的资深专家,毕业于斯坦福大学、哈佛大学、上海交通大学、复旦大学和中国科学技术大学等。研发能力覆盖工艺器件、架构设计、电路设计和软件生态等全链条;

其工程团队核心成员平均拥有25年以上的高端集成电路设计和量产经验,有着丰富的应用和产品化实战经历。

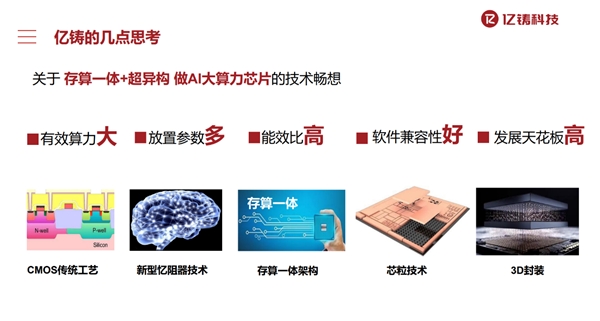

基于此,作为首发存算一体超异构概念的亿铸科技,提出了自己的技术畅想:

若能把新型忆阻器技术(RRAM)、存算一体架构、芯粒技术(Chiplet)、3D封装等技术结合,将会实现更大的有效算力、放置更多的参数、实现更高的能效比、更好的软件兼容性、从而抬高AI大算力芯片的发展天花板。

(关于存算一体+超异构 做AI大算力芯片的技术畅想图源:亿铸科技)

一方面,ChatGPT等大模型的发展对算力提出了史无前例的要求,吞噬着算力与能源;

另一方面,ChatGPT也为存算一体架构、超异构等技术带来核级推动力。无论是大厂和初创公司,都在为突破算力瓶颈“奋力一搏”。基于亿铸科技有最适合大算力的器件(RRAM),再加上3D封装和Chiplet等技术,熊大鹏博士表示,亿铸科技能够为解决存储墙、能耗墙问题带来杀手级的硬件解决方案。

在摩尔定律几近终结、ASIC、FPGA以及GPGPU架构能效比难以提升的当下,亿铸科技率先提出“存算一体超异构架构” 这一全新的技术发展路径,为我国AI大算力芯片进一步发展,增添了新的动能。

相关文章

- 苹果内部测试,Siri还是被ChatGPT甩好几条街

- OpenAI推出Windows版ChatGPT客户端

- ChatGPT对资源的需求越来越失去控制

- OpenAI ChatGPT用户激增至2亿,亚马逊/微美全息加速布局大模型市场蓝海

- 大众汽车将搭载集成ChatGPT的语音助手

- ChatGPT每周有2亿人使用,周活跃用户不到一年的时间就实现了翻倍增长

- AI视频ChatGPT时刻到来,昆仑万维发布全球首款AI短剧平台

- ChatGPT现在允许免费用户每天生成多达两张DALL-E 3生成的图像

- OpenAI称不会在ChatGPT文本上打水印,防止用户感到不满

- OpenAI开始为ChatGPT推出新的高级语音模式

- OpenAI ChatGPT软件安全漏洞:Mac版竟然以纯文本形式存储对话

- 机器人ChatGPT时刻近在咫尺,苹果/英伟达/微美全息探索AI机器人多元应用潜力

- 腾讯发布“腾讯元宝”ChatGPT免费用户已能使用GPT-4o新功能

- ChatGPT、Gemini、通义千问等一众大语言模型,哪家更适合您?

- Nothing 推出集成了 ChatGPT 的 Ear 和 Ear (a)

- 摄影界的ChatGPT来了!百度网盘推出AI摄影创意工具超能画布