谷歌:想发AI论文?请保证写的是正能量

2021-01-04 09:38:09爱云资讯619

谷歌一直是人工智能领域“产学研”结合的标杆,但最近这家公司与自己的科学家们的关系开始出现裂痕。

路透社近期的一份报道称,其从谷歌内部通讯和对相关研究人员的采访了解到,谷歌今年发起了“敏感话题”审查,希望以此加强对公司旗下科学家所发表的论文的控制。目前谷歌已经至少有三次要求相关作者避免对其技术进行负面评价。

这意味着,谷歌在官网上宣称公司的科学家们享有“实质性”自由,但事实可能正好相反。

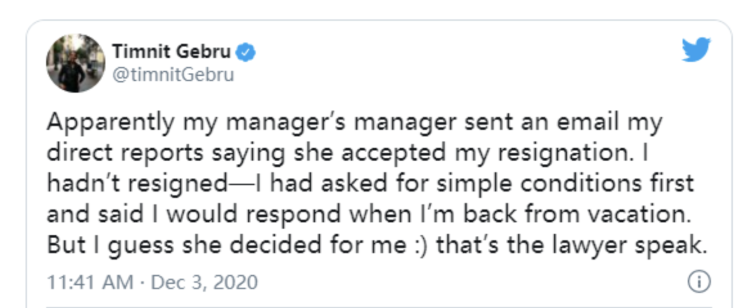

报道提到谷歌的前员工蒂姆尼特·格布鲁(Timnit Gebru),她曾与玛格丽特·米歇尔(Margaret Mitchell)共同领导一个12人的团队进行AI软件的伦理学研究。然而就在本月,她突然离开了谷歌,引发了外界对于谷歌和它旗下研究员之间关系的议论。

格布鲁认为,谷歌之所以辞退她是因为该公司曾禁止她发表关于语言模仿AI可能会对边缘化人群不利的研究,而她对此提出了质疑。而谷歌则宣称格布鲁是自己提出辞职,并且公司已经接受并加速她的辞职申请了。暂时还很难判断格布鲁的论文是否经历过“敏感话题”审查。

格布鲁在Twitter上就“被辞职”发声

谷歌高层对于此事也进行了回应。谷歌高级副总裁杰夫·迪恩(Jeff Dean)在本月的一份声明中说,格布鲁的论文只讨论了潜在的危害,而没有讨论为解决这些危害正在进行的努力。同时迪恩补充说,谷歌支持AI伦理学奖学金,并且“正在积极改善我们的论文审阅流程,因为我们知道太多的检查和制衡会(使审查流程)变得很繁琐。”

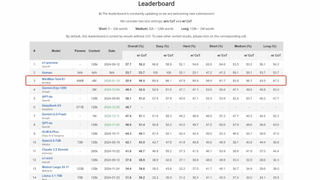

不过谷歌试图干涉学术研究并不是个例。据报道,一篇出自谷歌研究员之手的论文被要求“采取积极的态度”。这篇论文研究的重点是智能推荐技术,例如YouTube采用了这种技术来为用户提供个性化内容推荐。

路透社看到的论文草稿中提到了对这项技术的一些“担忧”,比如它可能会促进“虚假信息、歧视或其他不公平的结果”和“内容多样性的不足”,并导致“政治极化”。然而,最终发表的版本却称智能推荐系统可以促进“信息的准确性、公平性和内容的多样性”。

这篇论文最终以“你正在优化什么?使推荐系统与人类价值观保持一致”为标题发表,并且没有提到谷歌研究人员在其中的贡献。很难解释为什么会有这种情况发生。

近几年整个技术行业中AI的研究与开发激增,这也促使了美国和其他地方的主管部门提出了相应的监管要求。一些科学研究表明,面部分析软件和其他AI可以使偏见长期存在或侵犯隐私。而近年来谷歌在其整个服务中使用了大量AI技术,包括用AI来解析复杂的搜索需求,在YouTube上确定推荐内容并在Gmail中自动补全语句。

谷歌想必非常清楚外界的这些担忧和质疑,因此希望竭力营造出一种对AI系统的积极印象。迪恩表示,去年谷歌研究人员发表了200多篇有关负责任地开发AI的论文,而相关项目总共有1000多个。

但另一方面,研究谷歌服务中的偏见被该公司“敏感话题”政策所禁止。

同时报道还称,谷歌的新审查程序要求研究人员在从事面孔和情感分析,种族、性别和政治背景归类等研究主题之前要先咨询公司的法律、政策和公关关系团队。

“技术的进步和我们日益复杂的外部环境正在逐渐导致看似无害的项目引发道德、名誉、监管或法律问题”,相关文件这样解释公司出台新规的原因。这份文件的具体发布时间尚不清楚,不过三名谷歌的在职员工透露“敏感话题”政策始于今年六月。

在种种的限制之下,谷歌员工想要发表论文不再是易事。根据内部信件,一位谷歌研究人员为了在上周发表一份论文,与审阅者之间邮件往来100多次——他将这一过程比作“长征”。而且还不知道结局如何。

相关文章

- 三星与谷歌联手开发AR眼镜,Meta/微美全息硬件先行共绘XR未来蓝图

- 谷歌量子芯片重磅登场掀热潮,微美全息持续打造量子“芯”质生产力

- Meta携手卡梅隆共铸3D沉浸世界,谷歌/微美全息创新引领全息虚拟新纪元

- 抢先OpenAI Sora谷歌新推Veo模型,亚马逊/微美全息加入AI视频生成竞赛引关注

- 谷歌DeepMind发布Gemini 2.0人工智能模型

- 2025年AI Agent商用蓄势待发,微软/谷歌/微美全息纷纷入局重塑AI全产业链

- 谷歌发布突破性量子计算芯片Willow:五分钟完成超算10的25次方年的计算

- 预报天气更快、更准确!谷歌发布AI天气预测模型GenCast

- 谷歌文生视频模型Veo私人预览版在Vertex AI平台上线

- 谷歌Gemini作为原生应用登陆iPhone

- 谷歌推出Learn About实验性新AI工具,重塑学习新方式

- ChaGPT网页搜索引擎上线 OpenAI挑战谷歌

- 谷歌超过四分之一的新代码是由人工智能生成

- Meta在开发自己的人工智能搜索引擎,减少对谷歌和微软的依赖

- 谷歌宣布开源水印识别工具SynthID,可供开发人员和企业免费使用

- 谷歌将于11月21日起从搜索结果中移除站点链接搜索框