浪潮元宇宙服务器+NVIDIA Omniverse助力构建高逼真交互型数字人

2022-08-25 11:27:38爱云资讯1113

近日,在浪潮 & NVIDIA元宇宙算力发展研讨会上,浪潮信息和NVIDIA分享了如何使用浪潮元宇宙服务器MetaEngine与NVIDIA Omniverse快速构建高逼真的交互型数字虚拟人。

数字人生产需要强大的多元算力支撑

虚拟数字人是元宇宙的主要实体,就像是元宇宙世界中的公民,是人类身份在虚拟世界的载体。随着2021年元宇宙风起,更高拟真、超写实,具有强交互性的新一代虚拟人开始涌现,且正在被规模化应用到不同产业场景。

数字人生产可以拆分成人物建模、人物驱动、人物渲染和感知交互四个作业环节。AI能够加速虚拟数字人生产的每个作业环节,可以说AI正在改变数字人的生产范式,将数字人的创作周期大幅缩短,提升生产效率,推动数字人产业快速发展。

这样一种新范式的背后其实是更巨量和多元的算力需求。具体而言,数字人和其他实体的建模需要众多设计师协同创作完成,这就需要底层平台具有强大虚拟化和云端协同计算能力;当数字人建模完成之后,数字人自身的运动,数字人和其所处的数字环境、以及其他实体的相互作用需要大量的结构力学、弹性力学,以及多体动力学等物理仿真算力需求;让数字人无限接近自然人,需要高逼真、沉浸感的3D渲染,例如阿丽塔高度拟真的视觉特效来源于光线追踪、光栅化、DLSS等巨量的图形图像算力支撑;在智能交互环节,由AI驱动的数字人往往需要结合语音识别、NLP、DLRM等AI算法从而实现交互能力,这些模型的背后需要强大的AI算力来支撑其训练和推理。此外,现实世界和数字世界的交互则需要超低延迟的网络数据传输,来创造更流畅的沉浸式的数字世界体验。

由此可以看出,元宇宙的构建和运行需要强大的多元算力支撑。这也对算力基础设施提出了更高的要求,不仅是高性能、低延迟、易扩展的硬件平台,还需要有端到端、生态丰富、易用的软件栈。

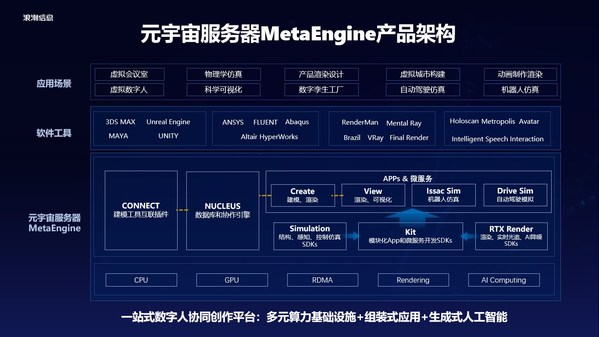

浪潮MetaEngine:元宇宙算力平台

浪潮元宇宙服务器MetaEngine就是要打造支撑元宇宙的软硬一体化算力基础设施。为此,浪潮与英伟达联合打造业界超强软硬件生态,为数字人和数字孪生的构建提供多元算力,以及丰富的技术和工具,为用户打造高效的元宇宙协同开发体验。

在硬件上,MetaEngine采用浪潮领先的异构加速服务器,支持最先进的CPU和GPU,具有强大的RDMA通信和数据存储能力,可提供强大的渲染和AI计算能力。

在软件上,MetaEngine可以支持对应每个作业环节的各类专业软件工具,用户可以根据使用习惯灵活选择。同时系统全面支持NVIDIA Omniverse Enterprise,是经过优化的OVX系统,可提供用于构建和部署大规模数字孪生的相关功能及性能。用户可以通过Kit功能将不同的SDK进行模块化的组合,快速完成定制化App或者微服务的开发。互联插件CONNECT可以通过通用数据格式USD实现第三方专业软件工具无缝连接,目前CONNECT已经提供了20多种Plugins,支持与3DS MAX,UE, MAYA等软件互联,解决不同软件之间难以打通、互操作性弱的痛点难题。

MetaEngine还整合了浪潮"源"大模型和浪潮AIStation智能业务创新生产平台的能力。浪潮"源"大模型参数规模高达2457亿,具备知识问答、多轮对话、中英翻译、写作古诗等零样本或小样本的推理能力,可以让虚拟人像人类一样进行自然语言交互。而针对浪潮"源"需要多GPU计算设备协同工作的问题,浪潮AIStation可实现多计算资源的智能调度管理,保证模型服务的高吞吐、低延迟。

浪潮MetaEngine - NVIDIA Omniverse快速构建高逼真交互型数字人

浪潮信息与NVIDIA强强联手,基于MetaEngine和NVIDIA Omniverse Enterprise推出了具备统一多软件格式、支持多人协作、支持实时驱动和实时光线追踪渲染的虚拟人解决方案,强大的算力平台及丰富的软件栈让虚拟人构建由难变易,尤其适合大规模虚拟人制作场景。

方案集成了创建数字人的流程和技术,可以快速生成毛发、皮肤、细节都非常逼真的超写实数字人,帮助数字人制作用户更好地创建自己的数字虚拟IP。

使用方案中的NVIDIA Ominiverse audio2face工具,通过很简短的一段音频输入,就可以驱动这段语音对应的表情,大大加速数字人的制作过程。

来源:NVIDIA “使用NVIDIA Omniverse auto2face制作AI驱动的面部动画”

在动作识别方面,以往采用光学和惯性动作捕捉技术,需要真人演员驱动,并使用大量的摄像头、传感器,制作难度大、成本高、周期长。现在,借助浪潮MetaEngine - NVIDIA Ominiverse方案,可以基于人体骨骼点二维运动特征向量进行动作识别,进一步映射到数字人躯体上,快速驱动数字人的表情和动作。

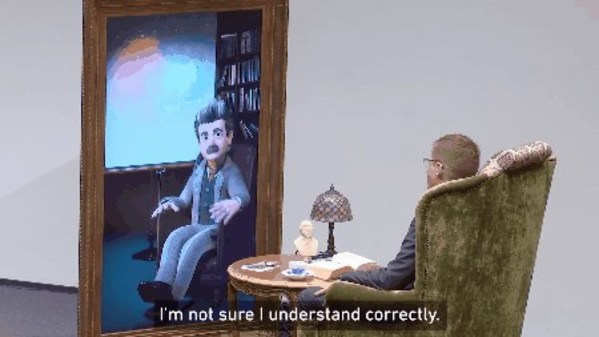

此外,还可以实现数字虚拟人和真实人类的交互。虚拟人可以识别真实人类的动作、肢体语言和反馈,再通过NLP模型、图形图像处理软件,根据机器学习算法决定说什么话,来吸引真实的人类,和人类进行交互。

来源:NVIDIA “与爱因斯坦虚拟人对话”

如何使用浪潮MetaEngine和NVIDIA Ominiverse来构建高逼真的交互型虚拟数字人呢?下面按照人物建模、人物驱动、人物渲染、感知交互的作业流程来说明。

首先可以使用UE metahuman等软件配合Omniverse的nucleus/connect进行3D人物形象及人脸建模。

然后通过高精仿真,让虚拟数字人的动作和行为更加物理准确。

接下来实时渲染环节,RTX Renderer可以提供实时渲染能力,让人物动画及其场景实时立体地展示在用户面前,通过屏幕或XR设备进行沟通交流。

最后是智能交互,这部分需要有大量的AI模型提供支撑。用户首先通过ASR和Vision AI模型进行语音和图像识别,进一步将识别得到的结果送入全球领先的中文语言模型浪潮"源1.0"大模型来生成应答的语言文本,在这个部分AIStation推理平台会负责管理源1.0及语音模型,源回答的结果,会经过tts模型转化为语音,然后送入NVIDIA Omniverse audio2face,通过语音驱动数字人面部产生逼真的表情及面部动作,并通过RTX Renderer实时渲染能力生成动画视频作为输出与用户交互,让对话及交互更加自然真实。

相关文章

- 浪潮云海携手Veritas,共创数据安全新纪元

- 山峰一号茶业发布“物华天宝”新品,深度融入“国潮”复兴浪潮

- 赞同科技:在AI浪潮中锚定金融场景创新,助力银行业数智化纵深发展

- 浪潮云海顺利通过CMMI V3.0 五级评估认证

- 集聚众智,共赢商业——华为商业市场携手伙伴,共赴全行业数智化浪潮

- 浪潮云“分布式智能云”战略发布,打通组织智能化落地“最后一公里”

- 苏姿丰亮相AMD AI PC创新峰会:AI是50年来最具变革性的技术 AMD赋能下一轮AI创新浪潮

- 浪潮KaiwuDB 携手 KWDB 开源社区走进南开大学

- 舒达宣布正式接入DeepSeek用AI解读智能睡眠报告,2025年再掀智能床革新浪潮

- 全球运营商AIoT峰会即将启幕!涂鸦智能携手T3科技、创维引领东南亚智能化新浪潮

- 浪潮软件率先推出政务服务大模型,重塑全场景应用

- 芯动力与联想携手打造独立加速器(dNPU)解决方案,赋能AI PC浪潮

- 钉钉C10圆桌派走进三亚:看见AI浪潮中的“她力量”

- 炬芯科技再发端侧 AI音频芯片 ATS362X 低功耗大算力引爆音频新浪潮

- 宇视亮相2025 ISLE:掀起新一轮的“智慧教育”、“高效协同”浪潮

- 浪潮信息:元脑企智DeepSeek一体机将举办生态伙伴推介体验会