飞桨框架2.0业界首发“通用异构参数服务器” 实现降本35%

2021-04-12 13:10:11爱云资讯阅读量:1,114

日前,美媒《华尔街日报》报道称:美国羡慕中国的基础设施,并希望加强基建以夯实美国经济增长。事实上,对“基础设施”的建设,除了短期内可拉动增长刺激就业外,更重要的意义是“有力地支持全领域共同繁荣”。我国的十四五规划中,“科技创新”成为焦点,加强科技的基础设施建设,从而更高效、高质量的实现全领域共同进步。中国科技新基建再次当先。

宜早不宜迟的“科技新基建”

人工智能是科技新基建的核心之一,而深度学习又是人工智能的先锋。自 2012 年深度学习取得突破性进展,众多深度学习框架应运而生,成为研究者和业界工作者的新宠。不管深度学习研发进行的多么火热,都要转化为生产力和商业价值,最终落地到产业中,而且宜早不宜迟。

实践鉴差距。“做不做得出来”跟“用不用得起来”差的完全是“从0到1”的决定性距离。从早期的学术框架 Caffe、Theano,到如今有业界背景的大规模框架Pytorch,TensorFlow以及国内最早开源的飞桨PaddlePaddle来看, AI新基建绝非一朝一夕可成,需要长期持续的投入和产业实践打磨,方可有所沉淀。

2016年,百度PaddlePaddle就打响了国产深度学习框架开源的第一枪,成为我国首个自主研发的产业级深度学习平台。2019 年 4 月,在 Wave Summit 深度学习开发者峰会上,PaddlePaddle发布中文名“飞桨”,开始强调自己更适合中国开发者,以及更加专注于深度学习模型的产业实践。2020年5月,飞桨作为百度大脑“AI大生产平台”的基础底座,构建“飞桨开源深度学习平台”和“飞桨企业版”,更精准地服务各类AI模型开发训练与部署。

其中,飞桨开源深度学习平台已涵盖核心框架、基础模型库、端到端开发套件与工具组件,为产业、学术、科研创新提供基础底座。飞桨企业版包括零门槛AI开发平台EasyDL和全功能AI开发平台BML,满足企业快速智能化需求。飞桨全平台功能与开发流程成熟完善,完全站在使用者角度定义技术迭代。今年3月,飞桨核心框架已正式升级为2.0版本。飞桨生态凝聚了超过265 万开发者,服务 10万多家企业,创建超过 34 万个模型。

权威数据调研机构IDC公布了2020年下半年深度学习框架平台市场份额报告, 数据显示,Google、百度、Facebook稳居前三,占据70%以上市场份额。其中,百度占比提升3.38%增速第一,综合市场份额位列第二。

高性能+高效率=万物皆智能、一切可编程

人类使用工具这事儿可以追溯到史前文明。工具的意义在于辅助劳动,省时省力,这也是飞桨作为工具存在的意义。能被广泛开发者用起来的工具也才是好工具。要知道,这个时代对于很多人来讲,抢时间就是抢市场、抢优势、抢夺竞争力。以飞桨最新发布的框架2.0正式版为例,更便利高效且通用的AI开发与训练部署,正方便着各个领域中的企业用AI技术建立自己的智能化领先优势。

具体来看,首先此次升级后,飞桨框架2.0 可支持用户使用动态图完成深度学习相关领域全类别的模型算法开发,这标志着飞桨的动态图功能已经成熟完备。不仅方便开发者随时查看变量输入、输出的动态情况,更有助于调试程序便捷化,减少了凭手感与玄学的“盲调”。同时,飞桨框架 2.0 还做到了模型存储和加载的接口统一,保证“动转静”之后保存的模型文件能够被纯动态图加载和使用。就像静态图像与动态视频一样,可以一键“高画质”互相转换,实际上是方便了使用端的操作。此外,官方支持的动态图算法数量达到了270+,涵盖计算机视觉、自然语言处理、语音、推荐等多个领域,并且在动态图的训练效率和部署效率方面都有所提升。

人工智能的价值,是通过软件编程实现虚拟化、灵活、多样和定制化功能,并最终向各个行业和人群提供专用的智能化、定制化服务。软件与硬件在深度融合时的核心就是API。AI时代里,API之上一切皆可编程,而API之下,则要求“如无必要不增实体”,所以API绝对是技术对外输出、以怎样的方式实现可用的关键点。飞桨框架2.0也对自身 API 体系进行了全新升级,包括体系化梳理和简洁化处理。简单来说,就是把AI技术对外的输出“路径”变得更加好用,更加兼容,方便技术的“一键输出”。

在训练层面上,飞桨框架2.0在支持万亿规模稀疏参数基础上,也已实现支持千亿规模稠密参数模型训练。作为“从实践中来,到实践中去”的技术,AI的可用性与高效性,必然都是从实践中获得的。分布式训练源自于百度自身的场景需求,可谓是飞桨与生俱来的特性。此外,在飞桨框架2.0 版本中,还新增支持了混合并行模式,即数据并行、模型并行、流水线并行这三种并行模式可以相互组合使用,可更高效地将模型的各网络层甚至某一层的参数切分到多张 GPU 卡上进行训练,从而真正支持不同场景下的千亿规模稠密参数模型训练。

“领先性”直接转化为“降本”

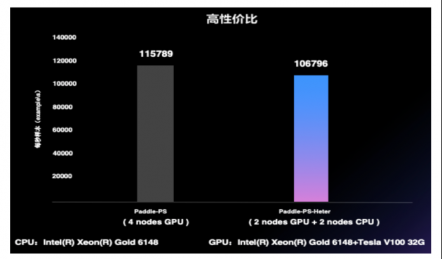

飞桨框架2.0推出业内首个“通用异构参数服务器”技术,可使训练任务对硬件型号不敏感,即可以同时使用不同的硬件混合异构训练。通过异构参数服务器模式,用户可以在异构硬件集群中部署分布式训练任务,目的是对不同算力的芯片高效利用,获得更高吞吐,更低资源消耗的训练能力。异构参数服务器拥有非常高的性价比,如下图所示,仅用两个CPU机器加两个GPU机器就可以达到与4个GPU机器相仿的训练速度,而成本至少可以节约35%。

飞桨还着力建起业界最为完备的硬件合作生态。作为一块“智能革命”的砖,AI必须哪里有需要就往哪里搬。所以如何“搬过去”就很关键了。飞桨全面深度适配各种人工智能硬件,除了英特尔、英伟达、ARM等诸多芯片厂商,还有飞腾、海光、鲲鹏、龙芯、申威等 CPU,并结合麒麟、统信、普华操作系统,以及百度昆仑、海光 DCU、寒武纪、比特大陆、瑞芯微、高通、英伟达等 AI 芯片深度融合。此外,还和浪潮、中科曙光等服务器厂商合作形成软硬一体的全栈AI基础设施。当前飞桨已经适配和正在适配的芯片或 IP达到 29款。

现如今,AI 的大规模落地已经步入快车道,深度学习技术不断发展,以飞桨为首的国产框架迎来时代机遇。2021 年,基于飞桨的企业级开发工具库数量越来越多,内容越来越丰富,加入飞桨生态社区的用户越来越多,它正在成为加速这个时代走向智能化的重要驱动力。可以说, 飞桨“技术赋能万物”的磅礴力量正在显现。

相关文章

- 摩尔线程加入飞桨硬件生态共创计划,加速人工智能生态和创新应用发展

- 十个大模型、六大发布 WAVE SUMMIT 2022飞桨持续夯实AI底座

- WAVE SUMMIT 2022将于5月20日召开 飞桨将迎来大规模升级

- 中科曙光×百度飞桨,以算力助跑开发者同台竞技

- 河南师范大学等27所高校联合百度飞桨推出“人工智能微专业”

- 百余位高校教师齐聚“云端课堂”,百度飞桨师资培训班落地重庆大学

- “创客北京2021”百度飞桨人工智能产业创新应用专项赛决赛圆满结束

- 2021全国人工智能师资培训走进北理工,百度飞桨助力高校教师提升AI能力

- 百度飞桨人工智能产业赋能中心于上海浦东启动运营

- 岳麓山下齐聚全国高校教师 飞桨深度学习师资培训开班助AI教学

- 支持更大规模产业应用!百度飞桨获KDD CUP 2021两金一银

- “创客北京2021”百度飞桨AI产业创新应用专项赛正式启动

- 开源生态融合,DeepModeling开源社区使用飞桨攻坚分子动力学

- 产教融合新范式 飞桨助力高校创新AI人才培养

- 融合创新 伙伴同行 飞桨推动产业走通AI工业大生产之路

- 飞桨全新发布推理部署导航图,助力打通AI应用最后一公里