让智能模型“说人话”背后:AI可知论与不可知论的纠葛缠斗

2019-04-14 08:52:54爱云资讯606

现如今人类对于AI的应用,就好像带妈妈去外面的餐厅吃饭,妈妈们不光要吃,还总想弄明白这些菜是怎样做成的。就如同神经网络越是高效,我们就越好奇黑箱里究竟发生了什么。

一直以来我们对于AI可解释性的追求可以被分为两层,一是从技术角度探寻神经网络黑箱的运行机制;二是从社会角度将AI技术原理更多地解释给各个行业。

虽然计算机科学家们一直没有停止对神经网络黑箱突破的探索,但也有人曾经明确地表示过,追求可AI的可解释性并不是什么好主意。

去年年底,谷歌大脑负责人Geoff Hinton就曾在接受媒体采访时说过若干“AI不可解释”的理由。其中很重要的一点是,他认为大多数人也没法很好的解释自己做出一种决策的理由,如果强迫人类对自己的行为做出解释,结果很可能就是让人类说出违心的谎言。AI也是一样,也许强行在AI算法中加入可解释性,得出的结果很可能只是一种“针对于解释需求的答案”,并不能发挥出人们所期望的作用。他可以说是一位坚定的“AI不可知论”支持者。

让AI模型说人话

不过在几天前,佐治亚理工学院就推出了一种让AI用人类语言解释自己行为的模型。

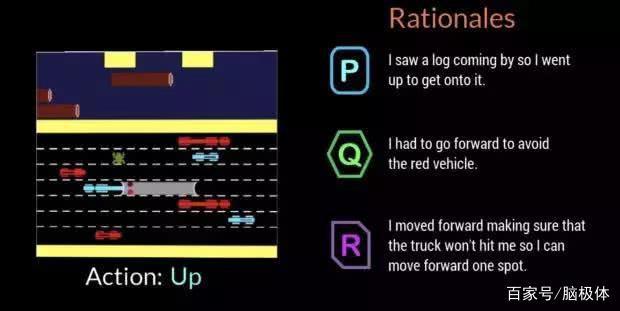

整个模型的训练过程,建立在一款“小青蛙过马路”的古老游戏上。游戏中玩家要操控着小青蛙前后左右躲避来往车辆,成功到达马路对岸。

佐治亚理工学院先是收集了大量的人类样本,让人类实验员玩一遍游戏,然后再回溯整个游戏过程,解释出自己的每一步动作有哪些意图。例如向左走是想躲避开后方来车,向前跳跃是因为漂浮的荷叶刚好来到自己面前。

这样一来,可以将自然语言与游戏控制结合在一起建立映射。将这一模型迁移到AI的训练中,最终结果是AI在每进行一步动作时,都会用自然语言解释出自己的意图。

实验者可以再根据四个维度对AI的行为和解释进行评分,这四个维度分别是“信任(认为AI的这一步行动是正确的)”“人性化(认为这是人类采取的行动)”“理由充分(语言解释和行为动作有相关性)”“可理解性(能看懂所给出的自然语言解释)”。

由此以来,就可以对AI的游戏能力和自我解释能力进行共同的训练。

佐治亚理工学院所研发的这一模型,为AI的可解释性带来不少全新角度的突破。

当AI进行错误决策时,我们可以清晰地看到AI究竟错在哪了。比如在游戏中小青蛙被路过的汽车撞死导致游戏失败,通过自然语言解释,我们可以看到可能是AI没有“想到”要躲避汽车而导致失败,还是已经“想到”了,却因想法和行为没能成功匹配而导致失败。在后期进行参数调整时可以更加有的放矢,明确地找到问题所在。

更重要的是,这一过程完全是由人类的自然语言所表达的,普通人也能看到并理解问题发生的整个过程。技术的可解释权不再受信息科技知识基础所限制,甚至可以让更多人参与到AI训练的过程中来。

AI可知论,是在开技术的倒车吗?

但“小青蛙模型”并不能解决Geoff Hinton提到的“AI不可知论”的很多问题。

首先,让人类描述自身行为,然后再将语言和行为建立对应关系的玩法适用度并不高。

在小青蛙过马路这样简单的游戏中,人类可以清晰明了地解释自己行为。但换个场景,很多时候我们就像Geoff Hinton所说的,自己也说不清自己做出决策的原因。尤其在一些场景,例如行车时是撞到马路上的动物还是撞到其他车辆,人们自身的选择常常陷入道德困境不能统一,和AI的决策模式有着天然的差异,就无法形成语言解释和行为之间的映射。

另一点则是,让AI“自我解释”这种行为,投入和产出比究竟如何?

我们知道自然语言处理是AI领域中一块相当难啃的硬骨头,如果“AI说人话”这种模式成为标配,结果恐怕就是让所有领域的AI模型都要进行相关的训练。也就是说,未来一家做智能客服产品的企业,为了AI的可解释性,需要招聘NLP领域人才;但未来一家人脸识别产品的企业,为了AI的可解释性,同样也需要招聘NLP领域人才……NLP专业学子或成最大赢家。如此为AI产业带来的巨大成本,又将怎样被覆盖呢?

世界在等待AI+X

在Geoff Hinton发表过那番“AI不可知论”后,有不少社会学专家进行了相关反驳。其中剑桥智能未来中心的研究员就提出,AI在事物效率上的提升和对于社会的影响,本来就不能分开讨论,Geoff Hinton这样的科学家,如果认为自己脱离了社会语境和政策语境,那么很可能在研究过程的一开始就走错了方向。

其实AI的可知论和不可知论之间,最核心的问题就是“AI出现了问题该怎么办?”

不可知论者认为,当AI出现了问题,我们就应该像算法训练过程一样,在发现问题后立刻进行针对性的训练和矫正。

但可知论者认为,如果我们等到AI在现实场景中出现问题再进行改善,一切就已经晚了。当前的要务是让更多社会角色参与到AI的研发过程中来,在广泛的现实应用之间就能够从多种角度发现问题。

正因如此,才会出现佐治亚理工学院这种“让AI说人话”的项目出现。而在AI学会说人话之前,AI与人之间、AI专家与其他专家之间,仍然会呈现出严重的沟通断层。在相当长的一段时间内,AI+X的跨领域人才,都将炙手可热。

相关文章

- 精彩回顾 | IJCAI 2022 China人工智能模型审计与监管论坛召开,聚焦模型知识产权保护

- IJCAI 2022 China专题论坛|人工智能模型审计与监管论坛

- 全球最大的超大规模智能模型“悟道2.0”发布,助力打造我国人工智能战略基础设施

- 智源大会开幕,全球最大智能模型“悟道2.0”发布

- 我国首个超大智能模型悟道发布,迎基于模型AI云时代

- 新突破!人工智能模型实现自动精准识别36种视网膜病变

- 人工智能模型服务商布尔数据获数千万元融资

- IBM推出AutoAI:允许企业人工智能模型开发自动化

- 让智能模型“说人话”背后:AI可知论与不可知论的纠葛缠斗

- 谷歌开发强化学习框架以培训人工智能模型

- 人工智能模型有望改进恶性脑瘤治疗 找到最小给药剂量和频率

- 探智立方iQubic正式发布人工智能模型自动设计平台DarwinML 1.0