未来几年,谁能拯救手机拍照功能?

2019-02-06 08:14:51爱云资讯1011

手机拍照作为刚需功能,一直是用户评判一款终端好坏的直接标准之一。受限于物理极限以及摩尔定律,摄像头和传感器实现“质”的飞跃,可能性不大。未来几年,手机摄影的突破点在于AI技术与元器件的深度融合。

近日,在商汤科技与艾瑞咨询联合发布的《2018年中国人工智能手机行业研究报告》中指出,2006年及以前,手机行业属于功能推动阶段,从一开始围绕接打电话到承载拍照、听音乐、上网等复合功能。2007年至2016年,市场变为性能推动阶段,配置成为商家逐鹿的方向。2017年之后,市场进入智能驱动的阶段。人工智能开始推动手机产品的迭代,硬件技术的升级需要软件技术地优化和凸显。

人工智能手机=AI芯片+AI功能,即“满足AI算力需求移动端芯片,且加载了深度学习AI功能的智能手机。”。AI芯片指内置独立神经网络计算单元,通过CPU、GPU、DSP及其他通用计算单元联动赋能。AI功能囊括人脸解锁、AI拍照、智能相册、AI智能助手等等。

报告显示,巨头厂商扮演了引领者的角色,多方面推动AI手机落地。2018年,我国4G渗透率达70%,手机市场3G向4G升级结构性红利渐失。部分硬件提升边际成本和收益不成正比。这种情况下,预计到2022年,搭载AI功能的智型手机出货量占比,将从2017年的不到10%提升到80%,年销量将超13亿部。AI手机将是未来行业的产品方向。

尽管在过去的2018年,AI人工智能手机噱头满满,不乏各种炒作以及不着边际地吹牛皮。但手机摄影取得的巨大进步,主要在于软件和硅层,而不是传感器和镜头等硬件。AI人工智能可以更好地理解,图像呈现的内容。预计未来几年关于手机摄影的常识,将会从硬件思维转变为AI思维。手机制造商们的人工智能技术水平,将会成为手机拍照功能好坏的主要判断标准,且这种趋势丝毫没有放缓的迹象。

2015年,谷歌上线的APP,清晰地展示了人工智能技术与摄影技术融合之后的照片。在此之前,谷歌一直试图通过机器学习技术对照片进行分类。谷歌的照片APP直接面向消费者提供人工智能服务,这对于大多数人而言,是难以想象的。“突然之间,用户可以从杂乱无章、数以千计的图片库,转换为可搜索的资料库”,“突然之间,谷歌就知道你的猫看起来像什么”。

据雷锋网了解,2013年,谷歌收购了多伦多大学一家神经网络方面的初创公司DNNResearch,用以推动谷歌基于语音和图片的搜索功能。该公司通过训练人类标记的数据,训练深度学习网络,此过程被成为监管学习(Supervised Learning)。具体而言,在数百万张图片上训练网络,以使得它能够通过像素级别的视觉线索,来帮助图片识别分类。随着时间的推移,算法将会识别得越来越准确。

比如,一个大熊猫,囊括了可以正确识别熊猫动物品类,黑色皮毛与白色皮毛的比例,以及和荷兰奶牛皮毛的区别。进一步训练以后,理解更加抽象的词汇成为可能。例如,“动物”、“早餐”等,对人类而言比较简单,但对机器来讲,属于没有视觉输出的词汇。

训练完以上的模型,需要大量的时间以及整理能力。一旦数据中心完成之后,它将可以以低功耗、便捷的方式在设备上运行。如今,前期这些繁重的工作已经完成,只要把照片上传到云端,谷歌就可以通过模型来分类、标记整个图片库。

谷歌图片功能发布大约一年之后,苹果发布了基于神经网络(类似谷歌)的搜索照片功能。但鉴于苹果用户隐私条例的承诺,苹果的分类功能实际上是在每个设备中单独进行的,设置后在后台进行,并不发送数据,用时长达一到两天时间。

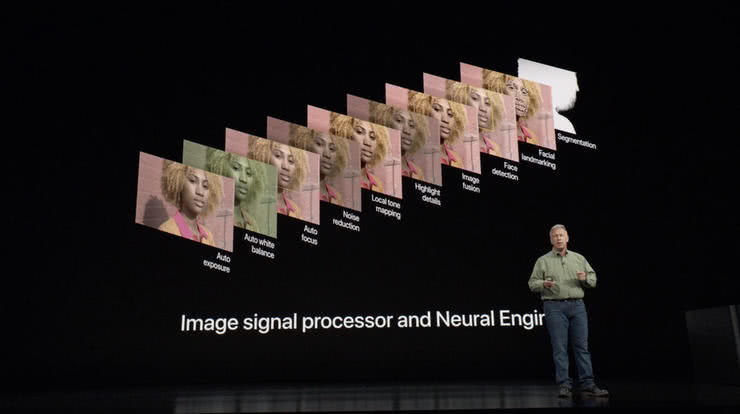

尽管和照片智慧管理是一回事,但人工智能和机器学习,毫无疑问,对于照片拍摄具有重大意义。摄像头和传感器可以“比大更大”,可是又起到怎样的作用呢?摄像头、传感器已经达到物理极限。如今,在某些情况下,手机拍摄的照片比传统照相机拍得更好已经不是什么“稀罕事”。其背后深层次原因在于,传统相机无法在芯片维度与手机竞争。手机芯片系统包括CPU、图像信号处理器、越来越多的神经处理单元NPU。

硬件的改变促成了计算摄影时代的到来,广义上的概念,涵盖了从人像模式的“假景深”到算法,一切计算形式,帮助手机拍摄出难以置信的手机照片。不是所有的计算摄影都包括人工智能,但人工智能肯定是重要的一个部分。过去,苹果手机正是基于此,驱动双摄像头的人像模式。iPhone一个摄像头的图像信号处理器通过机器学习区分人,另一个摄像头创建深度图隔离主体、模糊背景。

这项技能在2016年就出现了,所以,通过机器学习识别人并不是什么新生事物。照片软件组织(photo organization software)也早已经做到这一点,智能手机拍照的突破在于,实时性的处理速度。然而,谷歌才是这一领域的领导者,三代Pixel所展示出的结果令人信服。HDR+是一种默认的摄影模型,通过复杂的算法,融合几张曝光不足的帧合并为一帧。就像谷歌计算摄影的负责人Marc Levoy所言,“机器学习只会随着时间的推移变得更好,同谷歌照片软件一样,谷歌已经在一个巨大的、被标记的照片数据库上训练人工智能。进一步帮助相机的曝光,就像Pixel 2,产生了令人印象深刻的照片质量基准。”

前几个月,谷歌推出了Night Sight(夜景)功能,Pixel通过机器学习技术以长曝光来精准地预测白平衡和色彩。其中,Pixel 3效果最好,可能是算法随最新的硬件进行了迭代。这套算法适用于谷歌所有Pixel系列,甚至是缺少光学图像稳定性的工程机。这也从侧面说明了,于移动摄影而言,相机的软件比硬件更为重要。简而言之,在人工智能的“操持”下,硬件因此拥有了更大的提升空间。

据雷锋网了解,华为的Nova 4以及荣耀的View 20,首次采用了索尼IMX586图像传感器,4800万像素,意味着现阶段的最高级别分辨率。尽管如此,仍然需要在很多极其微小的单元填满像素,对图片质量产生不确定性影响。荣耀“AI Ultra Clarity”(人工智能超清晰)模式,擅长于最大限度地利用分辨率,解扰传感器不常见的色彩滤光器,释放出额外的细节。用户可以将图片放大,“海报”级照片应运而生。

图像信号处理器在某一段时间非常重要,随着计算摄影技术的进步,NPU将会发挥重要的作用。虽然苹果公司的A11仿生芯片最先触达消费者,但华为是率先宣布在自家麒麟970上,采用人工智能芯片的公司。全球最大的安卓处理器供应商高通公司,并未将机器学习作为战略重点。谷歌开发了自己的芯片Pixel Visual Core,用以帮助人工智能相关的图像处理。苹果最新的A12仿生芯片具有八核神经引擎,可以在core ML中运行任务,直接与图像处理器相连接,比A11快九倍。可以更好地对焦,生成更真实的景深。

所以,芯片对于对于机器学习的效率和性能至关重要。需要说明的是,谷歌的算法是在大型计算机上训练的,大型计算机拥有发达的GPU以及英伟达深度学习Tensor Core(张量计算核心),大部分工作可以“提前”完成。一旦将机器学习的计算能力搬运到移动端设备上,可以预见,在相当长的一段时间内,属于前沿性研究。

即使目前处于计算摄影的早期阶段,神经引擎可以减少手机拍照的处理负担,随时间的积累,运行速度越来越快。拍照作为任何手机最基本的功能,面部ID、人脸识别解锁、AR视频、AI人像、景物美化、相册智能分类、智能场景识图......在过去两年时间,已经深入渗透到普通人的日常生活中。

《2018年中国人工智能手机行业研究报告》显示,语音助手、人脸解锁、智能光线拍摄、美颜和识图成为2018年中国AI智慧手机用户最经常使的TOP5功能。人脸解锁、语音助手、随行翻译、智能光线拍摄、AI双摄/三摄、背景虚化成为用户认为最有价值的TOP5功能。

雷锋网认为,指数级增长遇到物理极限这个“天敌”,没有休止地持续增长逐步放缓。未来谁能够拯救停滞不前的移动摄影,答案不言自明!

相关文章

- 首届中国手机摄影大展在蜀启幕,vivo与中国摄影家协会共启全民移动影像创作新篇章

- 联通云智手机亮相中关村论坛 开启私人订“智”新时代

- 手机也能跑的模型来了!阿里宣布开源Qwen2.5-Omni-7B

- 亿道户外三防系列:五款三防手机与户外平板满足你的所有户外需求

- 智能手机的新物种:华为阔折叠手机HUAWEI Pura X

- 首款全面搭载HarmonyOS 5手机HUAWEI Pura X发布,鸿蒙应用新体验大有不同

- 荣耀MagicBook Pro 14将支持与iPhone手机互传 打造高效学习办公利器

- 近百款主流应用集体发声,共迎首款搭载原生鸿蒙正式版手机发布

- 三星Galaxy Z Flip 7折叠手机渲染图再度曝光:全屏外屏

- 内蒙古联通云手机率先与DeepSeek强势融合 共享云上美好生活

- 三星Galaxy S25+:超越期待的旗舰手机 智能体验全面升级

- 真我发布“耐玩战神“Neo7 SE系列:2000元内重构游戏手机新标杆

- AT&T和Verizon首次实现手机与卫星之间的视频通话

- 来京东搜索“DeepSeek”选购手机、电脑、学习机 感受人工智能新体验

- 2024年12月国内市场手机出货量3452.8万部,同比增长22.1%

- 三星Galaxy S25系列发布:AI驱动的智能手机新纪元