深度强化学习为人工智能系统注入“灵魂” 可让四足机器人自己学走路

2019-01-02 10:31:13爱云资讯1144

人工智能(AI)系统使得机器人能够以人类灵巧的方式掌握和操纵物体,现在,研究人员表示他们已经开发出一种算法,通过这种算法,机器可以自己学会走路。在Arxiv.org上发表的一份预印本论文中(“通过深度强化学习来学习走路”),加州大学伯克利分校的科学家和谷歌人工智能(AI)研究部门之一Google Brain描述了一种人工智能系统,教“一个四足机器人来穿越熟悉和不熟悉的地形。

“深度强化学习可以用于自动获取一系列机器人任务的控制器,从而实现将感知输入映射到低级别动作的策略的端到端学习。”该论文的作者解释道。 “如果我们可以直接在现实世界中从头开始学习运动步态,原则上我们就能获得最适合每个机器人、甚至适合单个地形的控制器,潜在地实现更好的敏捷性、能源效率和稳健性。”

设计挑战是双重的。强化学习是一种使用奖励或惩罚来驱动代替人实现目标的人工智能培训技术,它需要大量数据,在某些情况下需要数万个样本才能获得良好的结果。并且微调机器人系统的超参数 —— 即确定其结构的参数 —— 通常需要多次训练,这可能会随着时间的推移对腿式机器人造成伤害。

“深度强化学习已被广??泛用于模拟中的学习运动策略,甚至将它们转移到现实世界的机器人中,但由于模拟中的差异,这不可避免地导致性能损失,并且需要大量的手动建模。”该论文的作者指出,“在现实世界中使用这些算法已经证明具有挑战性。”

为了找到一种方法,用研究人员的话说,“(使)一个系统在没有模拟训练的情况下学习运动技能成为可能,他们选择了一种称为“最大熵RL”的强化学习框架(RL)。最大熵RL优化学习策略以最大化预期回报和预期熵,或者正在处理的数据中的随机性度量。在RL中,AI代理通过从策略中采样动作并接收奖励,不断寻找最佳的行动路径,也就是说,状态和行动的轨迹。最大熵RL激励政策更广泛地探索;一个参数 —— 比如说,温度 —— 确定熵对奖励的相对重要性,从而确定其随机性。

但这并不全是积极和有效的,至少不是一开始。因为熵和奖励之间的权衡直接受到奖励函数的规模的影响,而奖励函数的规模又影响学习速率,所以通常必须针对每个环境调整缩放因子。研究人员的解决方案是自动化温度和奖励规模调整,部分是在两个阶段之间交替进行:数据收集阶段和优化阶段。

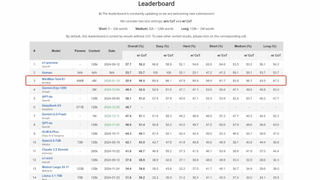

结果不言自明。在OpenAI的健身房(一个用于训练和测试AI代理的开源模拟环境)进行的实验中,作者的模型在四个连续运动任务(HalfCheetah、Ant、Walker和Minitaur)中实现了“几乎相同”或比基线更好的性能。

在第二次真实世界的测试中,研究人员将他们的模型应用于四足Minitaur,这是一种带八个执行器的机器人,一个测量马达角度的马达编码器,以及一个测量方向和角速度的惯性测量单元(IMU)。

他们开发了一个管道,包括(1)计算机工作站,更新神经网络,从Minitaur下载数据,并上传最新策略;(2)在机器人上安装Nvidia Jetson TX2执行上述策略,收集数据,并通过以太网将数据上传到工作站。经过两个小时160,000步的训练后,通过奖励前进速度和惩罚“大角加速度”和俯仰角的算法,他们成功地训练Minitaur在平坦的地形上行走,越过木块等障碍物行走,以及爬上斜坡和台阶,而这些在训练时间内均未出现。

“据我们所知,这个实验是深度强化学习算法的第一例,这种算法可以在没有任何模拟或训练的情况下,直接在现实世界中学习欠驱动的四足运动。”研究人员写道。

相关文章

- 2025中关村论坛丨百度王海峰:看到通用人工智能曙光

- 2025中国互联网科技大会暨中国人工智能应用发展大会在北京隆重启动

- 引领人工智能时代,天翼云息壤智算一体机获信通院权威认证

- 共筑AI产业新未来 2025人工智能基础设施峰会成功召开

- 全球AI巅峰盛会!2025 AGIC深圳(国际)通用人工智能大会暨产业博览会正式启航!

- 为国产化服务,为经开区赋能——国产化算力筑基人工智能之城

- 微软推出具备深度推理能力的Copilot人工智能助手

- 智启未来,共筑南海人工智能新高地 | 科大讯飞佛山人工智能产业基地正式成立

- 践行“人工智能+”行动 《北京新闻》聚焦四维图新地图众源更新创新应用

- 广州市委书记郭永航莅临钛动科技,深入调研“人工智能+出海营销”赋能中国企业全球化

- 苹果调整人工智能部门高管层 Vision Pro负责人接管Siri

- 金山云Q4 AI收入同比增长近500% 人工智能收入占比处行业领先地位

- 从“政务助手”到“故障预言家”,人工智能可以赋能哪些场景?

- 人民出行首批入选广西人工智能垂直模型,以科技投入带领行业前行

- 英矽智能完成1.1亿美元E轮融资,加速人工智能与机器人驱动的药物研发创新

- 人工智能+行动深化 第一线DYXnet私域DeepSeek方案助构AI智能体