美国科学家用AI算法转换大脑信号 失语人士未来有望“正常说话”

2019-04-29 13:08:44爱云资讯778

除了打字,失去说话能力的人还可以依靠什么方式与他人交流?人工智能或许带来了新的解决方案。

4 月 24 日,《自然》杂志刊登了加州大学旧金山分校的一项研究成果:科学家研发了一种实验性的“大脑解码器”,将研究对象的大脑信号与人工智能、语音合成相结合,从而帮助语言能力受损的人“说出”他们的想法。

许多疾病会导致人失去说话能力,比如中风、癌症,以及肌萎缩性脊髓侧索硬化症(俗称“渐冻症”)。著名科学家霍金就患有渐冻症,在很长的时间里,他只能借助轮椅上的电脑和几根手指与外界交流,每分钟拼出15-20个单词。2008 年病情恶化后,霍金连手指都无法再活动,唯一能控制打字的只剩下右脸颊的一块肌肉,打字速度下降到每分钟5-6个单词。

人的正常说话速度约为每分钟 150 个单词。研究人员希望借助“大脑解码器”,让苦于相关疾病的患者用正常速度与他人对话。

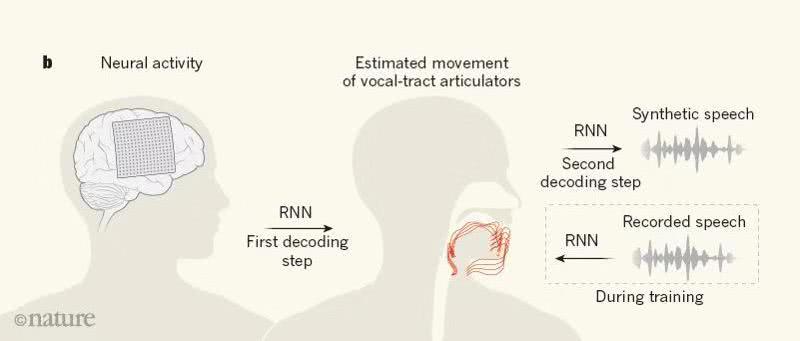

不过,“大脑解码器”并不能像科幻电影里那样直接“读心”。研究负责人、加州大学旧金山分校的神经外科学家Edward Chang介绍,解码的关键是声音系统的数据建模。

换言之,“大脑解码器”是通过比照说话时的大脑信号与发声部位的运动情况,推断出患者想说什么。

在实验中,研究人员找到了五名能正常说话的癫痫患者作为志愿者。为了治疗癫痫,这些患者的大脑表面被植入了能够监测电信号的电极,因此有条件开展额外的实验。

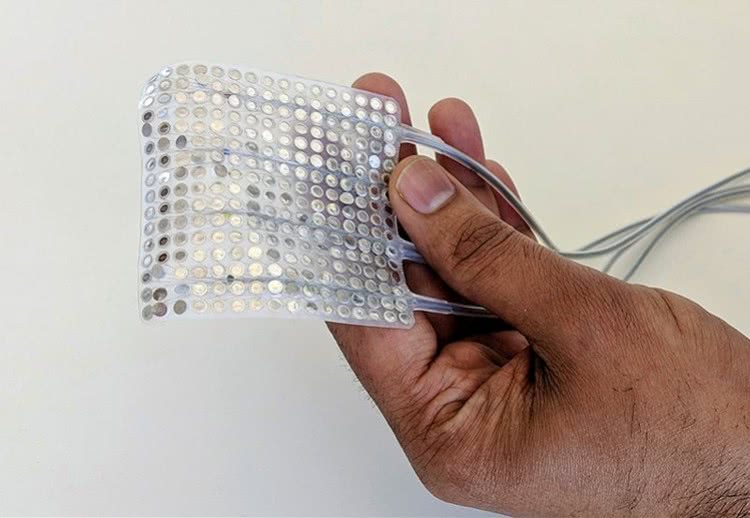

实验中使用的电极。图片源自加州大学旧金山分校。

一方面,研究人员要求患者大声朗诵数百个句子,并记录下大脑皮层信号。另一方面,研究人员记录了患者说话时的肌肉运动数据,涉及到舌头、嘴唇、下颌和喉部等地方的大约 100 块肌肉。打个比方,研究人员就像记录了一套“发声乐谱”,但乐谱上写的不是音符,而是一块块肌肉的运动情况。

接下来,研究人员用这些数据建模,训练出一套深度学习的算法,然后将其输入到解码器中。解码器对大脑信号进行转换,推算出相应的声道运动,再将这些运动转换为合成语音。

算法的转换过程。图片源自《自然》杂志。

圣地亚哥州立大学神经科学家Stephanie Riès对《自然》表示,通过声道运动的映射来合成语音,比直接将大脑信号转换为语音要容易理解得多。

不过,这套系统目前还停留在实验阶段,没有精确到足够应用的程度。芝加哥西北大学神经学家Marc Slutzky说,研究迈出了重要一步,但要使得合成语音易于理解,科学家们还有很长的路要走。

这个视频里展示了合成语音和原声的效果。跟原声相比,合成语音在某些发音上会显得不够清楚。视频来源:加州大学旧金山分校。

相关文章

- 顺网科技通过深度合成服务算法备案,AI算法构建沉浸式陪伴体验

- AI算法景区“找茬” 地下空间精准“扫盲” 红火吃穿游娱催热流量消费同比增长60%

- 人脸识别+全景双摄+AI算法 萤石推动智能锁行业革新

- 腾讯商世东:腾讯天籁自研AI算法,助力国产千元级助听器达到国际领先标准

- 腾讯推出「天籁inside助听器」,自研AI算法助力国产助听器关键性能提升85%

- “购吖”智能零售货柜:以AI算法+图像识别技术赋能零售行业

- 江苏气象x阿里云天池举办AI算法挑战赛圆满收官

- AI算法平台化,云天励飞助力城市治理数字化转型新突破

- 墨迹天气大数据搭配AI算法实现分钟级、公里级天气预报

- 自研AutoML驱动AI规模化时代,共达地AI平台一站式解决AI算法开发难题

- 萤石发布首款4K智能家居摄像机 支持AI算法自定义

- 解密AI算法赋能平台核心技术 ——特斯联半监督CV自训练学习算法

- 创新AI算法、辅助找房决策:百度地图好住计划用科技帮用户“住”得更好

- 腾讯优图发布2021十大人工智能趋势,AI算法的公平性和隐私保护问题受关注

- 美云智数AI算法开放平台荣获“数字化转型优秀解决方案”

- 诺奖得主来上海工作,用AI算法摘取生物学“皇冠上的明珠”