当神经网络遇上量子计算:谷歌证明量子神经网络可训练图像分类

2018-12-24 16:54:02爱云资讯763

谷歌人工智能量子(Google AI Quantum)团队最近发表了两篇论文,介绍了他们在理解量子计算机学习任务方面取得的新进展。

量子计算,它能给AI技术的发展带来什么帮助吗?

的确可以!

谷歌已经证明了量子计算也能解决传统机器学习中的图像分类问题,而且随着技术发展,量子计算机将在在学习能力上超越经典的神经网络。

另外量子计算还能解决经典网络中一些棘手问题,比如预防出现模型训练中的梯度消失问题。

量子神经网络

在第一篇论文中,谷歌构建一个神经网络的量子模型,研究如何在量子处理器上执行神经网络的分类任务。

谷歌把这个模型叫做量子神经网络(QNN),希望它能用在近期出现的量子处理器上。

虽然目前的工作主要是理论上的,但QNN的结构有助于在不久的将来对量子计算机进行实现和测试。

QNN可以通过标记数据的监督学习进行调整,谷歌已经在理论上证明了可以在MNIST数据集上训练它进行图像分类。

谷歌预计,随着量子计算机硬件规模的发展,未来QNN的能力将足够与经典神经网络匹敌,从而实现“量子霸权”。

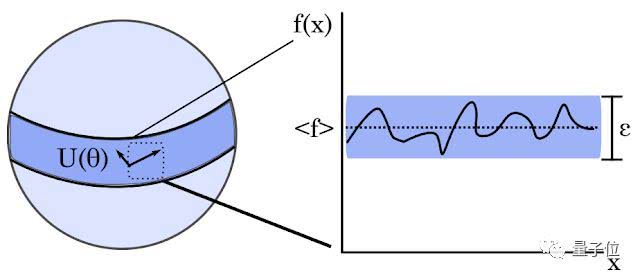

在第二篇论文中,谷歌专注于量子神经网络和经典神经网络训练中的关键难题,即梯度消失或爆炸(vanishing or exploding gradients)的问题。

在传统的神经网络中,神经元权重良好的、无偏见的初始猜测通常与随机性无关,但是在某些情况下也存在一些困难。

量子计算恰恰能解决这方面的问题。

谷歌的论文表明,量子几何(quantum geometry)的独特特征能够阻止某些不良的初始化情况产生,帮助我们进入到到函数的稳定区,防止选取到那些会导致梯度消失的初始化策略。

这项工作对未来初始化和训练量子神经网络的策略具有指导意义。谷歌希望从这些量子几何状态中能获得启发,实现训练网络的新算法。

实现量子霸权

谷歌今年在量子计算领域动作频繁。

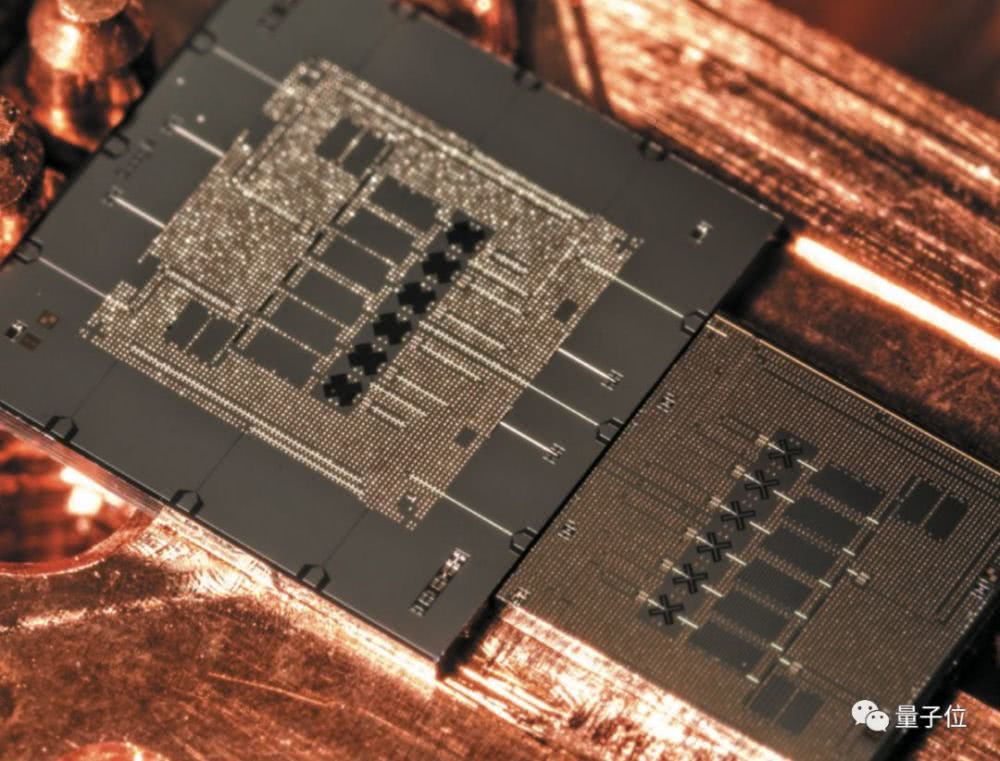

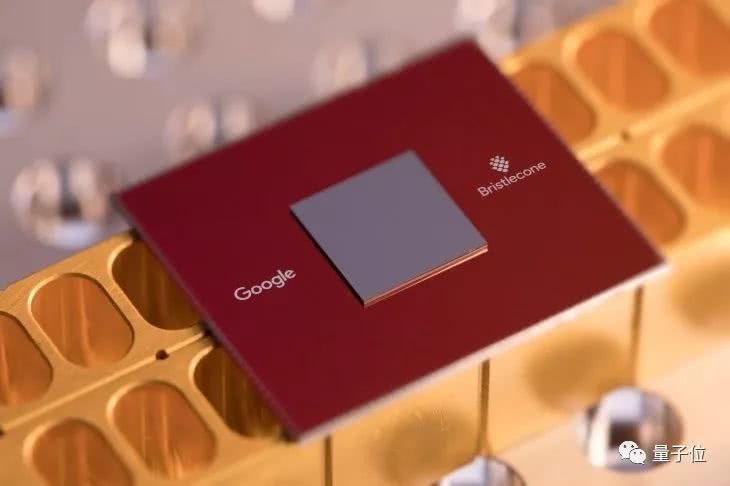

3月份,谷歌开发出了Bristlecone量子处理器,它拥有72个量子比特,是迄今为止最大的量子芯片。超过了IBM的50量子比特和英特尔的49量子比特。

谷歌希望用Bristlecone实现所谓量子霸权,即量子计算机在某些数学计算中的性能完全超过传统超级计算机。

NASA量子人工智能实验室(QuAIL)和谷歌一起,共同研究如何将“各种各样的优化和采样问题”映射到量子计算机上,希望在一年内实现该目标。

谷歌还计划在5年内实现量子计算技术的商业化。但这并不是说谷歌要推出面向市场的量子计算机。

由于超导量子计算机需要保持在接近绝对零度附近,因此不能把它从实验室里搬出来。预计谷歌届时会允许用户通过云API连接到量子计算机上。

相关文章

- Unity着手推进神经网络渲染技术应用,颠覆呈现虚拟 3D 世界的方式

- 科研成果发布│基于超图神经网络的推荐系统论文

- 打破神经网络技术应用局限性,度小满博士后论文入选国际顶级会议

- 本科生新算法打败NeRF,不用神经网络照片也能动起来,提速100倍

- 特斯拉AI DAY:AI神经网络解读 Dojo超算信息/AI机器人发布

- 2021世界人工智能大会AI Debate:图神经网络是否是实现认知智能的关键?

- 新专利显示苹果VR头显可能利用神经网络监测用户的姿势

- 图神经网络的知识提取与超越:一个有效的知识蒸馏框架

- 人工神经网络秒变脉冲神经网络,新技术有望开启边缘AI计算新时代

- 深度神经网络是为人工智能的重要基石

- Imagination推出新神经网络加速器 可用于ADAS和自动驾驶

- 深度学习与神经网络推动AI芯片市场以约40%的年成长率持续扩张

- 百度飞桨PGL-UniMP刷新3项任务记录 登顶图神经网络权威榜单OGB

- Helm.ai宣布了一种新的深度教学方法来训练神经网络

- 科学家们致力于利用神经网络改变神经成像研究

- 开发AI神经网络用于打假 阿里安全获计算机视觉顶会ECCV2020竞赛冠军