BOOM!新AI硬件加速器正在爆炸性增长!

2018-11-06 09:23:42爱云资讯阅读量:820

专业硬件平台是每一等级人工智能、机器学习和深度学习的未来,也是我们今后生活的云到边缘世界中每一项任务的未来。

人工智能的快速发展促进了机器学习和深度学习等新一类硬件加速器的爆炸式发展。

有人将其称为“寒武纪爆炸”,恰当地比喻了当前狂热的创新。寒武纪指的是大约5亿年前的一段时期,基本上每一种生物体都首次出现了“身体结构”。从那时起,这些生物——包括我们自己在内,开始四处迁徙,从而彻底改变了地球上的生态。

创新的人工智能硬件加速器架构的范围在不断扩展。虽然你可能认为图形处理单元(GPU)是主要的人工智能硬件架构,但这远非事实。在过去几年中,初创公司和成熟的芯片供应商都推出了令人印象深刻的新一代新硬件架构,适用于机器学习、深度学习、自然语言处理和其他人工智能工作负载。

除了新一代GPU之外,在这些新的人工智能优化芯片组架构中,最主要的是神经网络处理单元(NNPU)、现场可编程门阵列(FPGA)、专用集成电路(ASIC)和各种相关的方法,这些方法都被统称为神经突触体系结构。正如一些业界专家所指出的,今天的人工智能市场并没有像英特尔的X86 CPU(曾经主宰了桌面计算领域)那样只存在一种硬件架构。这是因为这些新的人工智能加速器芯片架构适应了迅速发展的云到边缘生态系统(如计算机视觉)中的各类特殊用途。

人工智能加速器芯片的发展

要想了解人工智能加速器芯片的快速发展,最好是关注一下本文介绍的市场机遇和挑战。

人工智能等级

要了解人工智能加速器是怎样发展的,看一看边缘,在那里,新的硬件平台正在被优化,以便让移动、嵌入式和物联网(IoT)设备具有更大的自主性。除了智能手机嵌入式人工智能处理器的快速发展之外,在这方面最值得注意的是人工智能机器人创新,涉及到从自动驾驶汽车到无人机、智能设备和工业物联网的方方面面。

在这方面最值得注意的进展之一是英伟达(Nvidia)进一步增强了其Jetson Xavier AI系列芯片的人工智能片上系统(SOC)。英伟达已经发布了Isaac软件开发工具包,以帮助构建运行在其专用机器人硬件中的机器人算法。

反映了智能机器人的复杂性,Jetson Xavier芯片由6个处理器单元组成,包括一个512核的Nvidia Volta张量内核GPU、一个8核的Carmel Arm64 CPU、一个双核的Nvidia深度学习加速器,以及图像、视觉和视频处理器。这些使其能够处理几十种算法来帮助机器人自主的感知环境,有效地进行响应,并与人类工程师一起安全地工作。

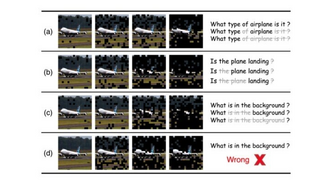

人工智能任务

人工智能加速器开始渗透到分布式云到边缘、高性能计算、超融合服务器和云存储架构的每一等级中。一股新的硬件创新浪潮正源源不断地涌向所有这些领域,以支持更快速、高效和准确的人工智能处理。

人工智能硬件创新正在走向市场,以加速这些不同应用环境中具体的数据驱动任务。市场上无数的人工智能芯片组架构反映了机器学习、深度学习、自然语言处理和其他人工智能工作负载的多样性——从需要大量存储的训练,到计算密集型推断,而且涉及不同程度的设备自主性和人在环路交互性。

为能够让人工智能芯片组适用于如此众多的工作负载,供应商在其系列产品中甚至在特定的嵌入式人工智能部署中混合了各种各样的技术,例如驱动智能机器人和移动应用的SOC。

作为一个例子,英特尔的Xeon Phi CPU架构已被用来加速人工智能任务。但英特尔认识到,如果没有专门的人工智能加速器芯片,它将无法与Nvidia Volta(在GPU中)以及大量生产NNPU和其他人工智能芯片的厂商相竞争。因此,英特尔现在有一个产品部门正在开发一款新GPU,并将在未来两年发布该产品。

同时,它继续看好人工智能优化芯片组的几类架构:神经网络处理器(Nervana)、FPGA(Altera)、计算机视觉ASIC(Movidius)和自动驾驶汽车ASIC(MobilEye)。它还计划为解决下一代人工智能挑战构建自学习神经形态和量子计算芯片。

人工智能的市场承受能力

每一人工智能加速硬件创新必须是可生存的,必须能够满足相关运行和经济承受能力指标。

在运行指标中,每一人工智能芯片组必须在外形封装、能效、散热和电磁辐射以及坚固性方面符合相关标准。

在经济指标中,它必须在性能和总体拥有成本方面具有竞争力,以满足其设计部署的等级和任务要求。比较行业基本标准将成为决定人工智能加速器技术是否具有在激烈竞争的市场中生存下去的性价比指标的关键因素。

在一个正在朝着工作负载优化人工智能架构发展的行业中,用户将在每一等级中采用最快、最具可扩展性、最具功效和成本最低的硬件、软件和云平台来运行自己的人工智能任务,包括开发、训练、运行和推断等。

人工智能加速器ASIC的多样性

人工智能加速器硬件架构并非单一化。它们是如此的多样化,发展的如此之快,以至于人们很难跟上这一市场不断创新的步伐。

除了Nvidia和Intel-ASIC等核心人工智能芯片组制造商之外,平台专用人工智能工作负载比比皆是。我们可以在最近的一些新闻中看到这种趋势:

● 微软正在为其HoloLens增强现实头盔准备一款人工智能芯片。

● 谷歌有一款特殊的NNPU——张量处理单元,可用于谷歌云平台上的人工智能应用程序。

● 据报道,亚马逊正在为其Alexa家庭助手设计一款人工智能芯片。

● 苹果公司正在开发一款人工智能处理器,用于Siri和FaceID。

● 特斯拉正在为其自动驾驶电动汽车开发一款人工智能处理器。

人工智能加速器基准框架开始出现

人工智能加速器市场中的跨供应商合作伙伴关系变得越来越复杂和重叠。例如,可以看看中国科技巨头百度是怎样分别与英特尔和英伟达合作的。除了推出自己的NNPU芯片进行自然语言处理、图像识别和自主驾驶之外,百度还与英特尔合作,在其公共云中实现FPGA支持的人工智能工作负载加速,还有用于Xeon CPU的人工智能框架,配有人工智能的自动驾驶汽车平台,具有计算机视觉功能的零售相机,并采用了英特尔的nGraph硬件无关深度神经网络编译器。这些发布紧随英伟达类似的公告,例如,将Volta GPU引入到百度云计划中,对百度Volta的PaddlePaddle AI开发框架进行调整,以及向中国消费市场推出英伟达支持的人工智能等。

面对如此令人眼花缭乱的人工智能加速器硬件选择和组合——无论是云还是在专门的SoC中,人们很难对其进行梳理。如果没有灵活的基准测试框架,要想针对任何任务找出人工智能加速器硬件对总体性能的贡献是非常棘手的。

幸运的是,人工智能行业正在开发开放的、透明的、与供应商无关的框架,以便在不同的工作负载中评估不同硬件/软件堆栈的相对性能。

MLPerf

例如,MLPerf开源基准测试部门正在开发一个标准套件,用于对机器学习软件框架、硬件加速器和云平台的性能进行基准测试。MLPerf可以在GitHub上使用,目前是测试版,为当今人工智能部署中占主导地位的一些人工智能任务提供了参考实现。它涉及到对具体算法(例如,Resnet-50 v1)采用具体数据集(例如ImageNet)执行具体的人工智能任务(例如图像分类)进行基准测试。核心基准测试集中于特定的硬件/软件部署,比如在Ubuntu 16.04、Nvidia Docker和CPython 2上运行的图像分类训练工作,这些平台由16个CPU芯片、一个Nvidia P100 Volta GPU和600G的本地硬盘组成。

MLPerf框架非常灵活,因此可以想象基于GPU的图像分类训练能够针对在不同硬件加速器(例如最近宣布的百度昆仑FPGA)上运行的相同任务进行基准测试——但是要在基本相同的软件/硬件堆栈中进行。

其他人工智能行业基准测试方案还允许在可替代的人工智能加速器芯片上进行比较性能评估,以及采用其他硬件和软件组件在部署中使用相同的模型对相同的训练或者运行数据来处理相同的任务。这些其他基准测试方案包括DawnBench、ReQuest、会话处理性能委员会的人工智能工作组和CEAN2D2。它们都足够灵活,可以应用于任何部署等级中运行的任何人工智能负载任务,并且经济上可行。

EEMBC机器学习基准测试套件

反映了人工智能工作负载向边缘的移动,一些人工智能基准测试方案完全集中于测量部署到这一等级的硬件/软件堆栈的性能。例如,行业联盟EEMBC最近开始了一项新工作,定义一个用于机器学习的基准测试套件,这些机器学习运行在功率受限的边缘设备的优化芯片组中。由英特尔主持,EEMBC的机器学习基准测试套件部门将使用来自虚拟助手、智能手机、物联网设备、智能扬声器、物联网网关和其他嵌入式/边缘系统的实际机器学习工作负载,以便确定用于加速机器学习推断工作的处理器内核的性能和功效。

EMEBC机器学习基准测试将测量低、中、高复杂度的推断任务的推断性能、神经网络加速时间,以及功效。它与机器学习前端框架、后端运行时环境和硬件加速器目标无关。该部门正在进行概念验证,并计划在2019年6月之前发布其第一版基准测试套件,以满足一系列神经网络架构以及基于边缘的推断应用情形需求。

EEMBC Adasmark基准测试框架

针对边缘层和任务较窄范围的应用,EEMBC的Adasmark基准测试框架重点是支持采用了人工智能的智能车辆。与其机器学习基准测试工作不同,EEMBC正在为高级辅助驾驶系统中嵌入的人工智能芯片开发一种单独的性能测量框架。

该套件有助于测量在多设备、多芯片、多应用智能车辆平台中执行的人工智能推断任务的性能。它对与高度并行的智能汽车应用相关的实际推断工作负载进行基准测试,例如,计算机视觉、自动驾驶、汽车环视、图像识别和移动增强现实等。它测量复杂智能汽车边缘架构的推断性能,通常包括多个专用CPU、GPU和其他硬件加速器芯片组,它们在共同的底盘上执行不同的任务。

新兴的人工智能应用场景

将需要更多的专业芯片

几乎可以肯定的是,会出现其他的专业人工智能边缘应用场景,它们需要自己的专用芯片、SoC、硬件平台和基准测试方法。人工智能芯片组的下一巨大增长领域可能是在用于加密货币挖矿的加速边缘节点上,这种应用场景与人工智能和游戏一样,需要大量的Nvidia GPU。

一个专门从事这一小众市场的供应商是DeepBrain Chain,该公司最近宣布了一个可以在分布式配置中部署的计算平台,帮助实现人工智能工作负载的高性能处理,以及挖掘加密货币令牌。挖矿站有两个、四个和八个GPU配置,还有独立工作站和128个GPU定制的人工智能高性能计算集群。

不久之后,我们几乎肯定能够看到专门用于分布式加密货币挖矿的新一代人工智能ASIC。

专业硬件平台是每一等级人工智能的未来,也是我们今后生活的云到边缘世界中每一项任务的未来。

作者:James Kobielus 是SiliconAngle Wikibon的人工智能、数据科学以及应用开发首席分析师。

相关文章

- 小度科技CEO李莹:AI硬件不光要“有用”,更要“有灵魂”

- AI硬件品类成交额同比增长200% 京东618开门红28小时战报出炉

- AI硬件爆发新一轮换机潮在即,TCL科技等面板龙头率先受益

- 科大讯飞双11战绩:星火大模型助力,AI硬件销售额同增126%

- 搜狗陈伟:搜狗分身将打通输入法、搜索、AI硬件等内部产品

- IBM投资AI硬件,计划10年内将AI性能提升1000倍

- 小度AI硬件切入教育场景,深耕内容覆盖千万儿童家庭

- 英特尔推出从云端到边缘的全新AI硬件,加速AI开发、部署和性能提升

- 出门问问携全系AI硬件齐亮相CESA 2019

- 英伟达AI战略:开发更好的AI硬件,做全球供应商

- IBM投资20亿美元建立新研究所,专注开发下一代AI硬件

- 麦肯锡:AI硬件为半导体公司带来新机遇 计算、内存和网络获得最大价值

- 百度大脑首发AI硬件 疯狂吸粉 观众严重“超标”

- 百度发布开源计算平台OpenEdge和AI硬件平台

- 腾讯优图公布三款AI硬件 深化To B能力!

- BOOM!新AI硬件加速器正在爆炸性增长!